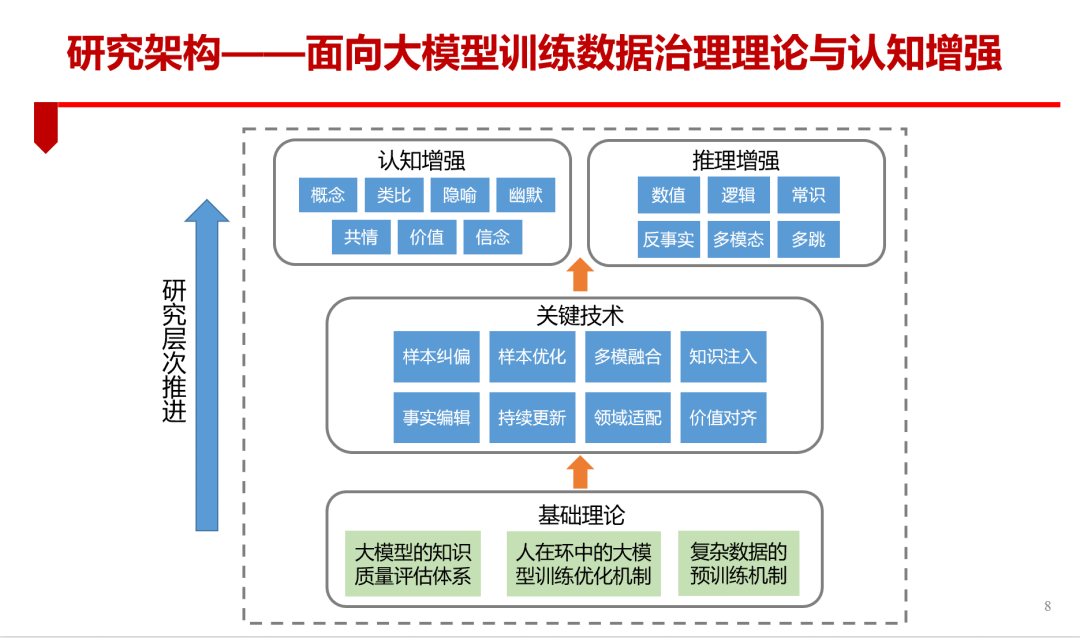

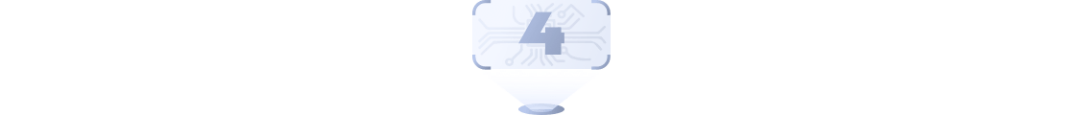

由 ChatGPT 引起的大模型热潮正席卷当下。众所周知,大模型的建立离不开海量数据,且大模型的最终效果取决于数据的质量,数据越丰富、质量越高,大模型表现效果越好。那么该如何针对大模型做数据的治理?2月26日,由CSDN、《新程序员》、上海市人工智能行业协会主办,百度飞桨、达观数据、智源人工智能研究院协办的全球人工智能开发者先锋大会(GAIDC)“新程序员:人工智能新十年”论坛,复旦大学教授肖仰华以“面向大模型的数据治理”为主题,分享前瞻洞察与思考。以下为肖仰华演讲内容,CSDN在不改变原意的基础上进行编辑:语言模型成为人工智能发展新底座,预训练的语言模型极大推动了自然语言处理(NLP)技术发展,成为语言智能的新范式、认知智能新底座。然而,大模型仍存在诸多问题:如隐私泄露,训练大型语言模型的数据集通常很大,并且数据源较丰富,它们可能涉及名称、电话号码、地址等敏感个人数据,即使以公开数据训练也是如此,这可能导致语言模型输出里涵盖某些隐私细节。还可能会出现事实错误、逻辑错误等问题。肖仰华表示,大模型要发挥价值,需要构建从数据产生、数据整理、模型训练、模型适配到实际部署的完整生态系统。大模型的数据治理是保障大模型质量的关键步骤,是当前国内在大模型研究方面极为稀缺的内容,是突破国外巨头对国内技术封锁的关键。基于此,面向大规模的数据治理研究,可从以下三层架构来思考:最底层是基于大模型的知识质量评估体系、人在环中的大模型训练优化机制、复杂数据的预训练机制等基础理论,往上为样本纠偏、样本优化、多模融合、知识注入、事实编辑、领域适配、价值对齐、认知提升等关键技术,最上层是认知增强和推理增强,研究顺序逐层推进。从上图中观察到,我们需重点建立大模型的知识质量评估体系,突破人在环中的大模型训练优化方法,探索序列、日志、图等复杂数据的预训练机制,提升大模型在特定领域与任务中的质量与性能。1、大模型的质量评估体系。目前国内的模型评估体系大部分关注语言层面,然而今天的大模型不单是语言智能的载体,在国外一些研究中,将大模型当做具备初级认知能力的智能体。因此在大模型质量评估上,不能仅仅停留语言处理层面进行评测,更多地,更为迫切是需要从人类认知的角度借鉴思路建立大模型的完整的评测体系,比如从认知发育理论借鉴理论指引,大模型是否具有可逆思维、创造思维、抽象思维、数值思维等能力,大模型是否存在认知偏见、是否存在认知障碍。大模型的评测关系到我们是否有资格成为裁判员。我们不能满足于只做运动员,我们更要成为裁判员,才能掌握大模型研究与应用的主动权。如今 ChatGPT 成功的重要原因是把对人类的反馈,通过强化学习的方式注入到大模型中。在ChatGPT中,人主要在以下两个方面发挥作用:一是利用人类的标注数据对GPT进行有监督训练,二是收集多个不同的监督模型(SFT)输出,由人类对这些输出进行排序并用来训练奖赏模型。那么这里面的基于排序的反馈是不是最佳的方式?有否更好的人类反馈方式?另外,如何让人以廉价成本实现高效大模型反馈?这里面仍有大量的问题需要研究和优化。3、复杂数据的预训练机制。针对代码、基因、图等复杂形态的数据,如何实现不同形态复杂数据的高效预训练?这里面存在大量的机会。在研究面向大规模预训练模型的数据治理理论与认知增强时,涉及样本纠偏、样本优化、多模融合、知识注入、事实编辑、领域适配、价值对齐、认知提升等关键技术。肖仰华表示,在 ChatGPT 赛道上,国内比国外发展稍晚。那么在通用大模型上,如何有机会实现弯道超车?我们不能被人牵着鼻子走,需要开辟大模型研究与应用的新赛道,在领域赛道形成核心竞争力。大模型有非常宽的知识底座,但是垂直领域的知识密集度以及推理复杂程度远远跟不上理论专家的要求和需求,因此我们不但需要有宽度的大模型,还需要有深度的大模型,来匹配领域需求。大模型样本纠偏是大家最早意识到的问题,大模型的效果与“喂”进去的数据息息相关。如果喂进有偏差的数据机器就学到有偏差的知识,因此我们需要纠正样本偏置,训练公平的大模型。大模型的异质多模融合是大模型实现跨模态理解的关键。目前很多大公司在做多模融合,但肖仰华建议“融合”不应局限在图片、语音、视频等,例如在工业场景,还涉及日志、传感器数据、图表等数据的融合。大模型本质上是统计模型,对于特定事实或信念的可控编辑存在巨大挑战。需要让大模型遗忘、记住特定事实,这是需要攻克的研究点。大模型缺乏人类的知识,特别是专业知识。如何将人类的各类认知,比如领域知识、概念层级、价值观念注入到大模型?肖仰华表示,做好大模型的特定可控编辑、大模型的知识注入,是大模型往领域推广和应用重要的问题。那么数学、物理、医疗、司法等知识如何植入进去?以往知识图谱构建大量的知识库,是大模型在领域落地重要的助力工具。现有模型多是基于一次性的构建过程,缺乏持续性知识获取能力,如缺失大量新兴实体(如新型冠状肺炎),充斥过时知识等。另外,认知智能系统需要持续知识更新能力以应对现代的知识爆炸性增长,当前的大模型训练代价太大,更新成本巨大、效率低下。针对大模型的持续更新,还需要大家做很多工作。大模型训练的数据良莠不齐,需要进行精心的样本选择、样本转换、样本清洗、提示注入,才能训练得到高质量大模型。肖仰华表示,还可以通过对大模型的异质来源数据进行来源提示的增强,来显著提升大模型的质量。肖仰华强调我们需重视大模型的价值对齐。目前现有大模型主要通过国外专家反馈训练,其价值观与国内有很大不同,通过对人类反馈的强化学习,实现大模型与人类价值的对齐,例如可通过构建匹配中式价值观的反馈训练样本,通过强化学习引导大模型生成符合伦理与价值观的回复。大模型通过感知与融合人类的反馈能够实现价值认知的对齐与增强。如在《Constitutional AI: Harmlessness from AI Feedback》提到,通过设定constitution,利用RLAIF(RL AI

Feedback)&RLHF,CoT等方法让大模型不逃避回答有争议问题,输出无害回答及解释。肖仰华表示,预训练语言模型虽已具备初级认知能力,但仍缺乏高级认知能力。可从概念、类比、幽默、价值认知等角度探索如何增强模型的高级认知能力。增强通用大模型的高级认知能力会是未来重要的研究方向,需要人工智能与人文学科的深度交叉融合,这既是巨大挑战,也是重大机遇。我们需要倡导人工智能与人文社科的深度交叉与融合的研究环境。对于人类来说,概念和实体间的知识可以互相迁移,以帮助我们理解新的陌生实体。语言模型虽然对语料库中频繁出现的概念和实体有一定了解,但它们仍对出现较少的冷门实体理解不足。现有工作将实体知识、知识图谱中的关系知识、句法知识、语义知识、外部文本知识用到预训练语言模型的学习中。然而,它们忽略了概念知识,一种对人类来说最为重要的知识。于是,一种全新的概念增强的预训练任务——实体概念预测(Entity Concept Prediction, ECP)诞生。对于语料中的提及的实体,ECP旨在预测出实体相应的概念。实体将以一定概率被遮盖住,即要求PLM仅基于上下文预测概念。类比是人类认知中最丰富和活跃的思维方式,类比是人类认知的核心,也是人类智能的核心。通过类比,人们可以证明日常的推理和发现新的见解,如老师用鸡蛋来类比地球的构造,学生很快理解了。类比推理是把两个或者两类事物或者情形进行比较,找出它们在某一抽象层面上的相似关系。并以这种关系为依据,将有关知识加以适当整理,对应到另一事物或情况,从而获得求解另一事物或情形的知识,类比推理是人类高级认知能力的重要体现。类比推理需要基于关系结构来实现源域到目标域的映射,从而帮助人类去学习和理解新的知识。现如今缺少大规模数据集让机器具备类比推离能力。通过更丰富的类比数据集,模型可以使用显式类比进行推理和解释,甚至训练专门的类比模型。2022年,复旦大学、字节跳动人工智能实验室等机构的研究者提出首个可解释的知识密集型类比推理数据集——E-KAR 数据集,由1,655个(中文)和1,251个(英文)来自中国公务员考试的问题组成,并提出了类比推理问题的两个基准任务,用于教会和验证模型学习类比的能力。隐喻本质是从源域概念到目标域概念的映射,基于相似性,反映了人类的认知过程。如在“今晚天空中有一团火”这句话中,通过“火红”这一特点将晚霞和火焰之间建立联系。让机器具备隐喻认知能力,便能让机器掌握事物间的内在联系。让机器具备隐喻相关推理的能力是实现类人智能非常关键的一个环节。大模型可以生成一些文本描述,但要做到优雅地生成很困难,为此复旦大学知识工场实验室建立了一些相关的数据集和知识库,在明喻解释上,取得一些研究成果:(1)明喻推理与解释:复旦大学知识工场实验室在《Can Pre-trained

Language Models Interpret Similes as Smart as Human?》中,提出明喻属性探测任务(Simile Property Probing),也即让预训练语言模型推断明喻中的共同属性。此工作从通用语料文本、人工构造题目两个数据源构建明喻属性探测数据集,规模为1,633个题目,涵盖七个主要类别。(2)大规模明喻知识库构建:构建大规模明喻知识库的系统 MAPS-KB,一个百万级别的明喻概率化知识库,规模为430万个明喻三元组,覆盖70GB的语料库。(3)面向明喻生成任务的自动评估指标 :为明喻改写任务设计全面、高效且可靠的评估系统。设计了五个评估准则:relevance、logical consistency、sentiment consistency、creativity、informativeness,并为每个评估准则设计评估指标。科学家认为,随着机器变得越来越聪明,幽默感也许是使人类区别于机器的最后一项特征。肖仰华表示,未来让大模型参与吐槽大会或说脱口秀也是有可能的。其中关键是增强大模型的能力,来检测幽默的笑点,甚至改写生成这些幽默段子。然而,幽默计算有以下挑战性:尚未建立完善的幽默理论,幽默难以形式化定义,当前研究只能处理一些简单形式的幽默。据肖仰华分析,预训练语言模型的幽默理解的第一个工作主要从预训练语言模型的幽默判定、识别、可解释三个方面来研究。随着人机交互系统和应用的发展,能否让机器具有幽默感可能预示着人机交互的通天塔能否建成。对此,肖仰华团队发布了中文幽默评估数据集。预训练语言模型的幽默理解的第二个工作主要从预训练语言模型的幽默改写、生成两个方面来研究。当前的语言模型在给出幽默响应方面表现不佳,预训练语言模型的幽默回复是自然语言处理中的一项挑战任务。缺乏大规模的幽默回复数据集和定制化的知识来提高预训练语言模型的幽默回复能力。对此,肖仰华团队发布了一个中文幽默回复数据集,定制化知识库和幽默回复辅助任务相关的数据集。在许多真实对话场景中,共情是十分重要的。如使用大模型诊断病人,医生在和病人交流的过程中,不单有医学知识,还需要共情能力,安慰病人等,共情能力非常重要。如何评测大模型与人类共情的水平?如何提升大模型与人类共情的能力?最近的一些报道称,在最新版本的GPT-3.5中,通过心智理论测试,大幅超越之前的版本,其正确率逼近人类九岁孩子的水平。总体而言这方面的研究仍需巨大努力。在研究的过程中,可能会发现这样一个问题:模型的信念容易受输入影响,对同一问题的回答摇摆不定。如何让模型拥有稳定的,正确的信念,以及更新特定信念?需要对信念检测、信念更新、信念强化等工作。肖仰华表示,预训练语言模型的推理能力有待加强,可从数值、逻辑、常识推理等角度探索如何增强模型的推理能力。大模型在不同领域应用时,需具备理解数值的能力。数值推理本质上是对自然语言文本中的数值实体进行区别与一般文本的特殊处理,包括将数值映射到数字线上的近似大小的量级化能力,以及对数值实体之间进行分析、思考以及符号化运算和推理的过程,反映了人脑具备的高级认知功能。对此,肖仰华表示,可通过构建量纲知识库、半自动化数量数据集构建、量纲认知的预训练增强、基于CoT的大模型数值推理等手段来增强数值推理能力。逻辑有“与或非”这三个原则,然而大模型在否定事实的生成上往往会犯错。因为否定事实是开放的,关于人不能做什么在语料中的描述是极度稀缺的。大模型的否定事实生成与理解能力因而大打折扣。肖仰华团队借助Chain-of-Thought,开展了一些研究工作,相关成果已经提交到学术会议。除此之外,还有常识推理增强、反事实推理增强、多模态推理增强、多跳推理增强等方法。目前科技巨头均在积极布局大模型,以国内为例,华为云发布盘古大模型,北京智源研究院发布“悟道”,浪潮发布中文巨量模型“源1.0”,阿里达摩院发布巨模型M6,百度联合鹏城实验室发布大模型“鹏城-百度•文心”,复旦大学知识工场团队也与超对称技术公司发布金融预训练语言模型BigBang

Transformer 乾元等。值得一提的是,在我们关注这些大模型的最新发展的同时,为充分发挥大模型的价值,保障大模型的质量,欢迎各位开发者和肖仰华博士一起,积极关注大模型背后的数据治理。肖仰华博士,复旦大学教授、博导、上海市数据科学重点实验室主任、复旦大学知识工场实验室负责人、复旦-爱数认知智能联合研究中心主任。关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/