校对:欧阳锦

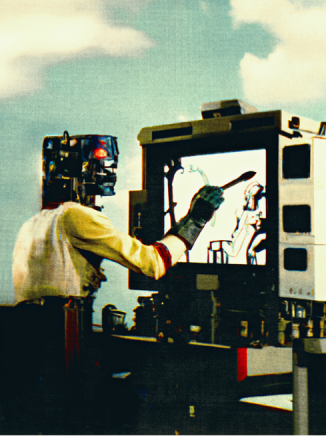

没有人知道OpenAI的DALL-E在2022年会那么受欢迎,也没有人知道它的崛起会留给我们什么。数字艺术家埃里克·卡特(Erik Carter)使用文本转换到图像的AI工具DALL-E2创作了这幅令人不安的图像。显然,OpenAI已经引起了一些轰动。2021年快结束的时候,一小队研究人员在该公司旧金山办事处正讨论一个想法。他们建立了OpenAI的文本到图像模型DALL-E的新版本,这是一种将简短的文字描述转换成图片的AI:可能是梵高画的狐狸,也可能是披萨做成的柯基犬。现在他们只需要弄清楚它的细节。OpenAI的联合创始人兼首席执行官萨姆·阿尔特曼(Sam Altman)告诉《麻省理工技术评论》(MIT Technology Review):“几乎任何时候,我们都会创造一些东西,然后必须使用它一段时间。我们试图弄清楚它会是什么,它会被用来做什么。”然而,这次没有成功。当他们修改模型时,所有参与者都意识到这是一件特别的事情。阿尔特曼说:“很明显,它就是一个产品,毫无争议,我们甚至从未就此举行过会议。”但是,没有人能够预测这款产品会带来多大的轰动,包括阿尔特曼以及DALL-E团队。阿尔特曼说:“这是第一个在普通人中引起关注的AI技术。”DALL-E 2于2022年4月上市。同年5月,谷歌宣布了(但没有发布)自己的两个文本到图像的模型——Imagen和Parti。然后是Midjourney,一个为艺术家制作的文本到图像的模型。8月,英国初创公司Stability AI向公众发布了开源模型Stable Diffusion。接下来的事情一发不可收拾:OpenAI在短短2个半月内注册了100万用户。在不到一半的时间里,超过100万人开始启用付费服务Dream Studio来使用Stable Diffusion;更多的人通过第三方应用程序使用Stable Diffusion,或在自己的电脑上安装免费版本。(Stability AI的创始人埃玛德·莫斯塔克(Emad Mostaque)表示,他的目标是10亿用户。)然后在10月,第二轮热潮到来:来自谷歌、元宇宙和其他公司的大量文本到视频的模型不断出现。它们不仅可以生成静态图像,还可以创建短视频剪辑、动画和3D图片。发展的速度是惊人的。在短短几个月内,这项技术占据了数百家报纸头条和杂志封面,在社交媒体上充斥着模因,让一台炒作机器超速运转,并引发了强烈的反弹。伦敦国王学院研究计算创造力的AI研究员迈克·库克(Mike Cook)表示:“这项技术的带来的轰动和敬畏是令人惊叹的,它很有趣,这就是新技术应该有的样子。但它的发展速度如此之快,以至于在你习惯这个想法之前,你的最初印象就已经被更新了。我认为我们从社会角度出发将花一段时间来消化它。”艺术家们正处于一代人最大的剧变之一的时刻。有些人会失去工作;有些人会找到新的机会。一些人正前往法院,就他们认为的那个挪用图像来训练可能会替代他们的模型的问题进行法律斗争。加州数字艺术家唐·艾伦·史蒂文森三世(Don Allen Stevenson III)曾在梦工厂(DreamWorks)等视觉特效工作室工作,他说,创作者们措手不及。“对于像我这样受过技术训练的人来说,这非常可怕。你会说,‘哦,我的上帝,这是我的全部工作。’在使用DALL-E的第一个月,我陷入了生存危机。” ?

? 上图是基于“一位艺术家在《异形》(1979)中使用AI艺术工具制作艺术”这一提示的变体。艺术家埃里克·卡特(Erik Carter)经历了一系列迭代,制作出了最终的图像(在顶部)。卡特解释道:“在获得满意的图像后,我进去做了调整,清理了所有AI人工制品,使其看起来更‘真实’。我是那个时代科幻小说的忠实粉丝。”尽管一些人仍在震惊中挣扎,但包括史蒂文森在内的许多人正在寻找使用这些工具的方法,并预测下一步会发生什么。令人兴奋的事实是,我们无法完全知道。因为虽然从娱乐媒体到时尚、建筑、营销等创意产业将首先受到影响,但这项技术将赋予每个人创造的超能力。从长远来看,它可以用于几乎任何东西的设计,从新型药物到服装和建筑,生成式革命已经开始。对于从事电子游戏和电视节目的数字创作者Chad Nelson来说,文本到图像模型是一个千载难逢的突破。他说:“这项技术能让你在脑袋里的想法在几秒钟内变成第一幅草图。你创造和探索的速度是革命性的,超过了我30年来所经历的任何速度。”在他们首次亮相的几周内,人们使用这些工具对杂志插图、营销布局到视频游戏环境和电影概念的一切进行了原型化和头脑风暴。人们创作了原创艺术,甚至是整本漫画书,并在数千人的网上分享。阿尔特曼甚至使用DALL-E来生成球鞋的设计,然后有人在他到推特上发这张图片后为他制作了相应的球鞋。伦敦玛丽女王大学的计算机科学家和纹身艺术家艾米·史密斯一直在使用DALL-E设计纹身。她说:“你可以和客户坐下来一起设计。我们正处于媒体生成式的革命中。”加州的数字和视频艺术家保罗·特里洛(Paul Trillo)认为,这项技术将使人们更容易、更快地对视觉效果进行集思广益。他说:“人们都说这是效果艺术家的死亡,或者是时装设计师的死亡。我不认为这是什么死亡。我认为这意味着我们不必在晚上和周末工作。”股票图像公司采取了不同的立场。盖蒂已经禁止AI生成的图像。Shutterstock已经与OpenAI签署了一项协议,将DALL-E嵌入其网站,并表示将启动一项基金,以补偿给那些工作是训练模型的艺术家。史蒂文森说,他在动画工作室制作电影的每一步都尝试过DALL-E,包括设计人物和环境。有了DALL-E,他能够在几分钟内完成多个部门的工作。他说:“对于那些因为太贵或太技术而无法创作的人来说,这是令人振奋的。但如果你不愿意改变,那就太可怕了。”纳尔逊认为还有更多的事情要做。最终,他看到这项技术不仅被媒体巨头所接受,也被建筑和设计公司所接受。不过,他说,它还没有准备好。“现在就像你有一个小魔盒,一个小巫师,”他说。如果你只想继续生成图像,这很好,但如果你需要一个有创意的合作伙伴,那就不行了。他说:“如果我想让它创造故事和构建世界,它需要对我正在创造的东西有更多的认识。”为了了解原因,让我们看看这些程序是如何工作的。从外部看,该软件是一个黑匣子。输入简短的描述——即一些提示,然后等待几秒钟,你将得到一些符合这个提示的图片(或多或少)。你可能需要调整你的文本来使模型产生更接近你的想法的东西,或者修饰一个偶然的结果。这被称为提示工程(prompt engineering)。提示最详细、最风格化的图像可能长达数百个单词,而争论得到正确的单词已成为一项宝贵的技能。网上市场如雨后春笋般出现,人们可以购买和出售已知的能产生理想效果的商品。提示可以包含指示模型选择特定风格的短语:“ArtStation上的趋势”告诉AI模仿ArtStation上流行的(通常非常详细的)图像风格,ArtStation是一个成千上万艺术家展示作品的网站;“虚幻引擎”调用了某些视频游戏熟悉的图形风格;用户甚至可以输入特定艺术家的名字,让AI制作他们作品的仿制品,这让一些艺术家非常不高兴。“我试图用‘大爆炸’这一提示来比喻AI,结果得到了这些抽象的气泡状形式(右)。这并不完全是我想要的,所以我就用‘20世纪80年代外太空爆炸的照片’(左)来表达,这看起来太激进了。我还尝试着种植一些数字植物,比如‘植物8位像素艺术’(中)。”更深层次,文本到图像模型有两个关键组成部分:其中一个神经网络被训练成将图像与描述该图像的文本配对,另一个从头开始被训练成生成图像。基本思想是让第二个神经网络生成图像,第一个神经网络接受该图像作为提示的匹配。新模型背后的重大突破在于图像的生成方式。DALL-E的第一个版本使用了OpenAI的语言模型GPT-3背后技术的扩展,通过预测图像中的下一个像素来生成图像,就像它们是句子中的单词一样。这起了作用,但效果不佳。阿尔特曼说:“这是一次神奇的经历。这一切都奏效了,真是令人惊讶。”相反,DALL-E2使用了一种叫做扩散模型的东西。扩散模型是经过训练的神经网络,通过去除训练过程中添加的像素化噪声来清理图像。这个过程包括拍摄图像,一次改变几个像素,经过许多步骤,直到原始图像被擦除,你只剩下随机像素。德国慕尼黑大学(University of Munich)的AI生成专家比约恩·奥默(Bj?rn Ommer)表示:“如果你这样做一千次,最终图像看起来就像你从电视机上拔下了天线电缆——那就是雪。”神经网络之后通过训练来逆转这一过程,并预测给定图像的像素化程度较低的版本会是什么样子。结果是,如果你给一个扩散模型一堆像素,它会尝试生成一些更干净的东西。将清理后的图像重新插入,模型将产生更干净的图像。这样做足够多次,模型可以把图片从电视雪转换到高分辨率图片。AI艺术生成器永远不会按照你想要的方式工作。它们通常会产生可怕的结果,充其量只能像扭曲的股票艺术。根据我的经验,真正让作品看起来好看的唯一方法是在结尾处添加一个具有美学美感的描述符。文本到图像模型的诀窍在于,这个过程由语言模型指导,语言模型试图将提示与扩散模型生成的图像相匹配。这将扩散模型推向语言模型认为的匹配良好的图像。但这些模型并不是凭空将文本和图像联系起来。今天,大多数文本到图像模型都是在一个名为LAION的大型数据集上训练的,该数据集包含从互联网上收集的数十亿对文本和图像。这意味着,你从文本到图像模型中获得的图像是现实世界的升华,因为它在网上表现出来,被偏见(和色情)扭曲了。最后一件事:两种最流行的模型DALL-E2和Stable Diffusion之间有一个小但关键的区别。DALL-E2的扩散模型适用于全尺寸图像。另一方面,Stable Diffusion使用了一种叫做潜在扩散的技术,这是Ommer和他的同事发明的。它在神经网络中编码的图像的压缩版本上工作,在所谓的潜在空间中,只保留图像的基本特征。这意味着Stable Diffusion需要更少的计算能力。与运行在OpenAI强大服务器上的DALL-E 2不同,Stable Diffusion可以在(好的)个人计算机上运行。创造力的爆炸和新应用的快速发展,很大程度上是因为Stable Diffusion是开源的,程序员可以自由地改变它,在它的基础上构建,并从中赚钱;而且足够轻便,可以让人们在家里运行。

上图是基于“一位艺术家在《异形》(1979)中使用AI艺术工具制作艺术”这一提示的变体。艺术家埃里克·卡特(Erik Carter)经历了一系列迭代,制作出了最终的图像(在顶部)。卡特解释道:“在获得满意的图像后,我进去做了调整,清理了所有AI人工制品,使其看起来更‘真实’。我是那个时代科幻小说的忠实粉丝。”尽管一些人仍在震惊中挣扎,但包括史蒂文森在内的许多人正在寻找使用这些工具的方法,并预测下一步会发生什么。令人兴奋的事实是,我们无法完全知道。因为虽然从娱乐媒体到时尚、建筑、营销等创意产业将首先受到影响,但这项技术将赋予每个人创造的超能力。从长远来看,它可以用于几乎任何东西的设计,从新型药物到服装和建筑,生成式革命已经开始。对于从事电子游戏和电视节目的数字创作者Chad Nelson来说,文本到图像模型是一个千载难逢的突破。他说:“这项技术能让你在脑袋里的想法在几秒钟内变成第一幅草图。你创造和探索的速度是革命性的,超过了我30年来所经历的任何速度。”在他们首次亮相的几周内,人们使用这些工具对杂志插图、营销布局到视频游戏环境和电影概念的一切进行了原型化和头脑风暴。人们创作了原创艺术,甚至是整本漫画书,并在数千人的网上分享。阿尔特曼甚至使用DALL-E来生成球鞋的设计,然后有人在他到推特上发这张图片后为他制作了相应的球鞋。伦敦玛丽女王大学的计算机科学家和纹身艺术家艾米·史密斯一直在使用DALL-E设计纹身。她说:“你可以和客户坐下来一起设计。我们正处于媒体生成式的革命中。”加州的数字和视频艺术家保罗·特里洛(Paul Trillo)认为,这项技术将使人们更容易、更快地对视觉效果进行集思广益。他说:“人们都说这是效果艺术家的死亡,或者是时装设计师的死亡。我不认为这是什么死亡。我认为这意味着我们不必在晚上和周末工作。”股票图像公司采取了不同的立场。盖蒂已经禁止AI生成的图像。Shutterstock已经与OpenAI签署了一项协议,将DALL-E嵌入其网站,并表示将启动一项基金,以补偿给那些工作是训练模型的艺术家。史蒂文森说,他在动画工作室制作电影的每一步都尝试过DALL-E,包括设计人物和环境。有了DALL-E,他能够在几分钟内完成多个部门的工作。他说:“对于那些因为太贵或太技术而无法创作的人来说,这是令人振奋的。但如果你不愿意改变,那就太可怕了。”纳尔逊认为还有更多的事情要做。最终,他看到这项技术不仅被媒体巨头所接受,也被建筑和设计公司所接受。不过,他说,它还没有准备好。“现在就像你有一个小魔盒,一个小巫师,”他说。如果你只想继续生成图像,这很好,但如果你需要一个有创意的合作伙伴,那就不行了。他说:“如果我想让它创造故事和构建世界,它需要对我正在创造的东西有更多的认识。”为了了解原因,让我们看看这些程序是如何工作的。从外部看,该软件是一个黑匣子。输入简短的描述——即一些提示,然后等待几秒钟,你将得到一些符合这个提示的图片(或多或少)。你可能需要调整你的文本来使模型产生更接近你的想法的东西,或者修饰一个偶然的结果。这被称为提示工程(prompt engineering)。提示最详细、最风格化的图像可能长达数百个单词,而争论得到正确的单词已成为一项宝贵的技能。网上市场如雨后春笋般出现,人们可以购买和出售已知的能产生理想效果的商品。提示可以包含指示模型选择特定风格的短语:“ArtStation上的趋势”告诉AI模仿ArtStation上流行的(通常非常详细的)图像风格,ArtStation是一个成千上万艺术家展示作品的网站;“虚幻引擎”调用了某些视频游戏熟悉的图形风格;用户甚至可以输入特定艺术家的名字,让AI制作他们作品的仿制品,这让一些艺术家非常不高兴。“我试图用‘大爆炸’这一提示来比喻AI,结果得到了这些抽象的气泡状形式(右)。这并不完全是我想要的,所以我就用‘20世纪80年代外太空爆炸的照片’(左)来表达,这看起来太激进了。我还尝试着种植一些数字植物,比如‘植物8位像素艺术’(中)。”更深层次,文本到图像模型有两个关键组成部分:其中一个神经网络被训练成将图像与描述该图像的文本配对,另一个从头开始被训练成生成图像。基本思想是让第二个神经网络生成图像,第一个神经网络接受该图像作为提示的匹配。新模型背后的重大突破在于图像的生成方式。DALL-E的第一个版本使用了OpenAI的语言模型GPT-3背后技术的扩展,通过预测图像中的下一个像素来生成图像,就像它们是句子中的单词一样。这起了作用,但效果不佳。阿尔特曼说:“这是一次神奇的经历。这一切都奏效了,真是令人惊讶。”相反,DALL-E2使用了一种叫做扩散模型的东西。扩散模型是经过训练的神经网络,通过去除训练过程中添加的像素化噪声来清理图像。这个过程包括拍摄图像,一次改变几个像素,经过许多步骤,直到原始图像被擦除,你只剩下随机像素。德国慕尼黑大学(University of Munich)的AI生成专家比约恩·奥默(Bj?rn Ommer)表示:“如果你这样做一千次,最终图像看起来就像你从电视机上拔下了天线电缆——那就是雪。”神经网络之后通过训练来逆转这一过程,并预测给定图像的像素化程度较低的版本会是什么样子。结果是,如果你给一个扩散模型一堆像素,它会尝试生成一些更干净的东西。将清理后的图像重新插入,模型将产生更干净的图像。这样做足够多次,模型可以把图片从电视雪转换到高分辨率图片。AI艺术生成器永远不会按照你想要的方式工作。它们通常会产生可怕的结果,充其量只能像扭曲的股票艺术。根据我的经验,真正让作品看起来好看的唯一方法是在结尾处添加一个具有美学美感的描述符。文本到图像模型的诀窍在于,这个过程由语言模型指导,语言模型试图将提示与扩散模型生成的图像相匹配。这将扩散模型推向语言模型认为的匹配良好的图像。但这些模型并不是凭空将文本和图像联系起来。今天,大多数文本到图像模型都是在一个名为LAION的大型数据集上训练的,该数据集包含从互联网上收集的数十亿对文本和图像。这意味着,你从文本到图像模型中获得的图像是现实世界的升华,因为它在网上表现出来,被偏见(和色情)扭曲了。最后一件事:两种最流行的模型DALL-E2和Stable Diffusion之间有一个小但关键的区别。DALL-E2的扩散模型适用于全尺寸图像。另一方面,Stable Diffusion使用了一种叫做潜在扩散的技术,这是Ommer和他的同事发明的。它在神经网络中编码的图像的压缩版本上工作,在所谓的潜在空间中,只保留图像的基本特征。这意味着Stable Diffusion需要更少的计算能力。与运行在OpenAI强大服务器上的DALL-E 2不同,Stable Diffusion可以在(好的)个人计算机上运行。创造力的爆炸和新应用的快速发展,很大程度上是因为Stable Diffusion是开源的,程序员可以自由地改变它,在它的基础上构建,并从中赚钱;而且足够轻便,可以让人们在家里运行。

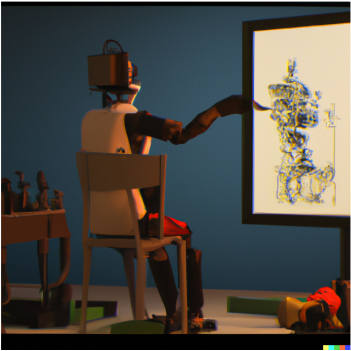

对一些人来说,这些模型是迈向人工通用智能(AGI)的一步,AGI是一个被过度炒作的流行词,指的是具有通用功能甚至类似人类能力的未来AI。OpenAI已经明确了实现AGI的目标。出于这个原因,阿尔特曼并不在乎DALL-E 2现在与一系列类似的工具竞争,其中一些是免费的。“我们来这里是为了制造AGI,而不是图像生成器,”他说。“它将适合更广泛的产品路线图。这是AGI将要做的一个小元素。”这是乐观的,至少许多专家认为。今天的AI永远不会达到这个水平。就基本智能而言,文本到图像模型并不比支持它们的语言生成AI更聪明。GPT-3和Google的PaLM等工具会从它们训练的数十亿份文档中提取文本模式。类似地,DALL-E和Stable Diffusion再现了数十亿个在线示例中的文本和图像之间的关联。结果令人眼花缭乱,但用力过猛,幻想破灭了。这些模型产生了基础性错误——对一张切碎的鱼片漂浮在下游的照片回复为“河里的三文鱼”,或者对有一只会飞的哺乳动物和一根木棍的照片做出“蝙蝠飞过棒球场”的反应。这是因为它们是建立在一项技术之上的,而这项技术远不能像人类(甚至大多数动物)那样理解世界。即便如此,这些模型学习更好的技巧可能只是时间问题。库克说:“人们不会说它现在在这方面不太好。但在1亿美元之后,很可能会这样。”阿尔特曼说:“我们已经知道如何将其提高10倍。我们知道有一些逻辑推理任务被它搞砸了。我们将列出一系列问题,并将推出一个新版本来解决当前的所有问题。”如果关于智力和理解的说法被夸大了,那么创造力呢?在人类中,我们说艺术家、数学家、企业家、幼儿园的孩子和他们的老师都是创造力的典范。但了解这些人的共同点很难。对一些人来说,最重要的是结果。另一些人则认为,事物的制作方式以及在这个过程中是否有意图至关重要。尽管如此,许多人还是回到了英国萨塞克斯大学(University of Sussex,UK)有影响力的AI研究者和哲学家玛格丽特·博登(Margaret Boden)给出的定义。博登将这一概念归结为三个关键标准:有创意的、必须是新的、令人惊讶的、有价值的想法或人工制品。(to be creative, an idea or an artifact needs to be new, surprising, and valuable.)除此之外,当你看到它时,你往往会意识到这一点。被称为计算创造力的领域的研究人员将他们的工作描述为使用计算机产生的结果,如果这些结果是由人类单独产生的,则会被认为是有创造力的。因此,史密斯很乐意称这种新的生成模型具有创造性,尽管它们很愚蠢。“很明显,这些图像中存在着不受任何人类输入控制的创新,”她说,“从文本到图像的转换往往令人惊讶和美丽。澳大利亚墨尔本莫纳什大学(Monash University)研究计算创造力的玛丽亚·特蕾莎·利亚诺(Maria Teresa Llano)同意,文本到图像模型正在扩展以前的定义。但利亚诺并不认为他们有创造力。她说,当你经常使用这些程序时,结果可能会变得重复。这意味着他们没有达到博登的部分或全部要求。这可能是这项技术的根本限制。通过设计,一个文本到图像的模型产生了与已有的数十亿图像相似的新图像。也许机器学习只会产生模仿过去所接触到的图像。这对计算机图形来说可能无关紧要。Adobe已经在Photoshop中构建文本到图像的生成;Photoshop的开源表兄弟Blender有一个Stable Diffusion插件。OpenAI正在与微软合作开发Office的文本到图像的小部件。 ?DALL-E 2接受图像或文字作为提示。上图是通过将埃里克·卡特的最终图像上传回DALL-E2作为提示创建的。正是在这种互动中,在这些熟悉的工具的未来版本中,真正的影响可能会被感受到:来自那些不取代人类创造力,但却增强了创造力的机器。“我们今天看到的创造力来自于系统的使用,而不是系统本身,”Llano说道——从所需的来回、呼叫-响应中产生你想要的结果。这一观点得到了其他计算创造力研究者的赞同。这不仅仅是关于这些机器的功能;还包括它们的做法。将它们变成真正的创意伙伴意味着推动他们更加自主,赋予它们创造性的责任,让它们策划和创作。这方面很快就会到来。有人已经编写了一个名为CLIP Interrogator的程序,该程序可以分析图像,并提示生成更多类似的图像。其他人正在使用机器学习,用旨在提高图像质量和保真度的短语来增强简单提示,有效地自动化提示工程,这项任务只存在了几个月。与此同时,随着图片的泛滥,我们也在打下其他基础。库克说:“互联网现在开始将永远被AI制作的图像污染。从现在起,我们在2022年制作的图像将成为任何模型的一部分。”我们将不得不等待,看看这些工具将对创意产业和整个AI领域产生什么样的持久影响。阿尔特曼说,他现在在个人信息中使用生成的图像,就像以前使用表情符号一样。“我的一些朋友甚至懒得生成他们键入提示的图像,”他说。但文本到图像模型可能只是一个开始。生成式AI最终可以用于从新建筑到新药(从文本到X)的所有设计。纳尔逊说:“人们将意识到,技术或工艺不再是障碍,而仅仅只是他们的想象能力。”计算机已经在多个行业中被用于生成大量可能的设计,然后再对其进行筛选,以找出可能有效的设计。文本到X的模型将允许人类设计师从一开始就对生成过程进行微调,使用文字来指导计算机通过无限多的选项获得不仅可行而且令人满意的结果。计算机可以创造出充满无限可能性的空间。文本到X将让我们用文字探索这些空间。阿尔特曼说:“我认为这就是遗产。图像、视频、音频最终都会产生。我认为它会渗透到所有地方。”Generative AI is changing everything. But what’s left when the hype is gone??https://www.technologyreview.com/2022/12/16/1065005/generative-ai-revolution-art/顾伟嵩,中国科学院大学网络空间安全专业研究生。对数据科学领域充满好奇,渴望探索未知世界。课余时间喜欢踢足球、游泳。愿意挑战新事物,结交新朋友,一起进步,一起成长。

?DALL-E 2接受图像或文字作为提示。上图是通过将埃里克·卡特的最终图像上传回DALL-E2作为提示创建的。正是在这种互动中,在这些熟悉的工具的未来版本中,真正的影响可能会被感受到:来自那些不取代人类创造力,但却增强了创造力的机器。“我们今天看到的创造力来自于系统的使用,而不是系统本身,”Llano说道——从所需的来回、呼叫-响应中产生你想要的结果。这一观点得到了其他计算创造力研究者的赞同。这不仅仅是关于这些机器的功能;还包括它们的做法。将它们变成真正的创意伙伴意味着推动他们更加自主,赋予它们创造性的责任,让它们策划和创作。这方面很快就会到来。有人已经编写了一个名为CLIP Interrogator的程序,该程序可以分析图像,并提示生成更多类似的图像。其他人正在使用机器学习,用旨在提高图像质量和保真度的短语来增强简单提示,有效地自动化提示工程,这项任务只存在了几个月。与此同时,随着图片的泛滥,我们也在打下其他基础。库克说:“互联网现在开始将永远被AI制作的图像污染。从现在起,我们在2022年制作的图像将成为任何模型的一部分。”我们将不得不等待,看看这些工具将对创意产业和整个AI领域产生什么样的持久影响。阿尔特曼说,他现在在个人信息中使用生成的图像,就像以前使用表情符号一样。“我的一些朋友甚至懒得生成他们键入提示的图像,”他说。但文本到图像模型可能只是一个开始。生成式AI最终可以用于从新建筑到新药(从文本到X)的所有设计。纳尔逊说:“人们将意识到,技术或工艺不再是障碍,而仅仅只是他们的想象能力。”计算机已经在多个行业中被用于生成大量可能的设计,然后再对其进行筛选,以找出可能有效的设计。文本到X的模型将允许人类设计师从一开始就对生成过程进行微调,使用文字来指导计算机通过无限多的选项获得不仅可行而且令人满意的结果。计算机可以创造出充满无限可能性的空间。文本到X将让我们用文字探索这些空间。阿尔特曼说:“我认为这就是遗产。图像、视频、音频最终都会产生。我认为它会渗透到所有地方。”Generative AI is changing everything. But what’s left when the hype is gone??https://www.technologyreview.com/2022/12/16/1065005/generative-ai-revolution-art/顾伟嵩,中国科学院大学网络空间安全专业研究生。对数据科学领域充满好奇,渴望探索未知世界。课余时间喜欢踢足球、游泳。愿意挑战新事物,结交新朋友,一起进步,一起成长。关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

?

?

?

?

关注网络尖刀微信公众号

关注网络尖刀微信公众号

大数据文摘

大数据文摘