来源:图灵人工智能

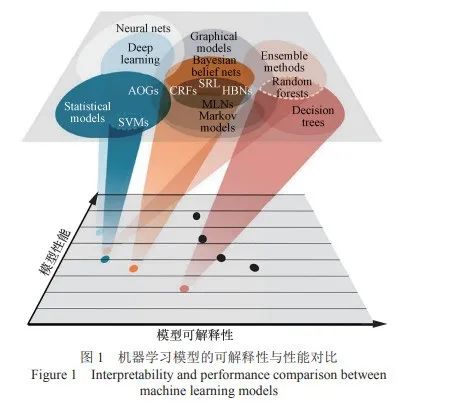

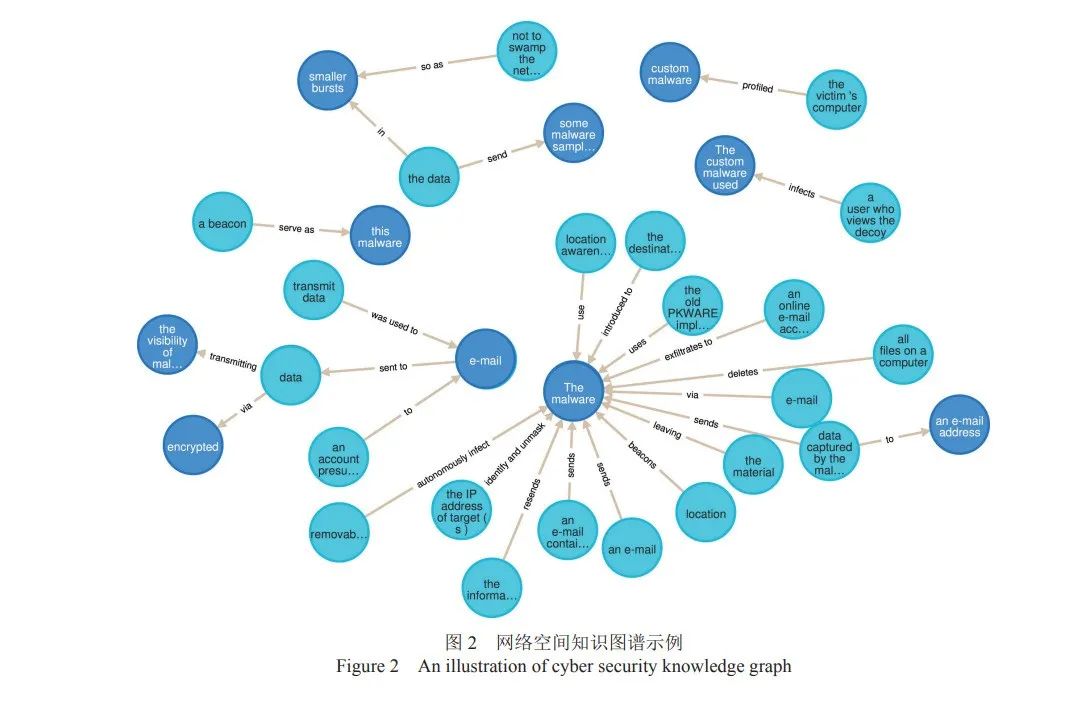

近年来,以深度学习模型为基础的人工智能研究不断取得突破性进展,但其大多具有黑盒性,不 利于人类认知推理过程,导致高性能的复杂算法、模型及系统普遍缺乏决策的透明度和可解释性。在国 防、医疗、网络与信息安全等对可解释性要求严格的关键领域,推理方法的不可解释性对推理结果及相关 回溯造成较大影响,因此,需要将可解释性融入这些算法和系统中,通过显式的可解释知识推理辅助相关 预测任务,形成一个可靠的行为解释机制。知识图谱作为最新的知识表达方式之一,通过对语义网络进行 建模,以结构化的形式描述客观世界中实体及关系,被广泛应用于知识推理。基于知识图谱的知识推理在 离散符号表示的基础上,通过推理路径、逻辑规则等辅助手段,对推理过程进行解释,为实现可解释人工 智能提供重要途径。针对可解释知识图谱推理这一领域进行了全面的综述。阐述了可解释人工智能和知识 推理相关概念。详细介绍近年来可解释知识图谱推理方法的最新研究进展,从人工智能的 3 个研究范式角度 出发,总结了不同的知识图谱推理方法。提出对可解释的知识图谱推理研究前景和未来研究方向。随着信息技术的不断发展,人工智能实现了 从能存会算的“计算智能”,到能听会说、能看会 认的“感知智能”[1-3],再到下一阶段具备理解、 推理和解释能力的“认知智能”[4-6]的逐渐演变, 这 3 个阶段的实现难度和价值同时逐次提升。然 而,在以深度学习为主导的人工智能技术中,大 多数的模型是不透明的,即模型在产生高精度结 果的同时,不能提供必要的解释过程。模型的不 可解释性严重影响了人们对模型决策的信任程 度,其可靠性和鲁棒性均受到广泛质疑[7],特别 在国防、医疗和网络与信息安全等领域的许多关 键应用[8-11]中,保证系统所做出的决策具备透明 性和可解释性是非常重要且必要的。知识推理是人类智能活动的重要组成部分, 一直以来也是人工智能的核心研究内容之一。DeepMind 指出人工智能算法必须具备推理能力, 且推理过程需要依靠人的先验知识[12],对推理的 结果形成必要的解释。作为目前知识推理最新的 知识表达方式,知识图谱[13]技术是一种实现可解 释人工智能的可能解决方案[14],通过将不同数据 源中的数据统一结构,实现对多源信息的语义网 络建模,为真实世界的各个推理任务提供概念、 关系和属性等可解释因素。 以安全领域的知识图谱为例,该领域主要包 括网络空间测绘图谱、漏洞知识图谱、恶意样本 知识图谱、攻击路径推理图谱等。通过威胁建模 的方式,对多源异构的网络安全领域信息进行加 工、处理、整合,转化成为结构化的安全领域知 识库,实现从威胁实体和关系的视角出发,识别威 胁以及对威胁进行评估。同时,在从图谱海量数据 中挖掘、推理威胁的实体相关信息过程中,只有通 过可解释的知识推理方法,才能进一步为推理结果 的安全可靠提供保证,提高威胁分析的效率。 在长期的研究和实践过程中,研究人员相继 总结了有关知识图谱推理的不同技术,并尝试从 不同的角度(如推理长度[15]、分布式表示[16]、图 嵌入[17])对推理模型进行综述。然而,对于推理 模型的可解释性则缺少相关的总结与对比。同时, 人工智能的可解释性越来越受到人们的重视,可 解释知识推理在近几年的学术界和工业界中逐渐 成为关注热点,知识推理领域缺少较为全面且详 细的针对可解释知识图谱推理的综述文章。 本文通过广泛整理与可解释知识图谱推理相 关的文献,在介绍相关知识推理的基本概念及可 解释性定义的基础上,从人工智能研究范式的角 度出发,详细阐述符号主义中的可解释知识图谱 推理方法、行为主义中的可解释知识图谱推理方 法、连接主义中的可解释知识图谱推理方法和新 型混合的可解释知识图谱推理方法,详细说明了 在不同场景下,各类可解释知识图谱推理方法的 核心思想及改进过程。本文还讨论了可解释知识 图谱推理的未来研究方向及前景。目前业界较为认可的可解释性定义为“可解 释性是一种以人类认识、理解的方式给人类提供 解释的能力”[5]。虽然人工智能技术不断取得突破性进展,高 性能的复杂算法、模型及系统却普遍无法向人类 用户解释它们的自主决策和行为,缺乏决策逻辑 的可解释性[18]。如图 1 所示,很多机器学习方法 在模型性能和可解释性之间存在不平衡现象,往 往模型越复杂越难以解释[14],这对模型后期的应 用和优化产生很大的影响,因此人们大多基于经 验来调整模型参数以达到优化模型的目的[19],然 后通过观察结果来判定操作的正确与否,充满盲 目性与随机性,忽略了模型可解释性的重要性。 可解释性对于用户有效地理解、信任和管 理人工智能应用至关重要[6],它与深度神经网 络中“黑匣子”的概念形成鲜明对比。不可解 释的模型在实践中经常出现难以预测正确结果 的情况,这在低风险的环境中,不会造成严重 后果(如视频推荐系统),而对于可靠性要求较 高的系统则很危险[20](如医疗、法律和信息安 全领域),模型必须解释如何获得相关预测。可 解释人工智能(XAI,explainable artificial intelligence)则提供了一种信任的基础,在此基 础上,人工智能才能在更大范围发挥作用,有助 于识别潜在的错误,进而改进模型[4],提高信息 服务质量,满足道德和法律的规范要求,为用户 提供更智能的服务。知识图谱是人工智能的核心技术之一[13],作为 一种新型的知识表示方法,知识图谱中包含大量的 先验知识,并以结构化三元组的形式组织海量信息, 通过实体和关系的形式将不同的数据源进行关联和 深度融合。目前,大量的知识图谱,如 Yago[21]、 Dbpedia[22]和 Freebase[23]已经开发,相关技术已被广 泛应用在智能问答[24]、推荐系统[25]和信息安全[26]等 任务中,其突出表现在学术界与工业界均获得了广 泛关注[27-28]。网络空间知识图谱示例[29]如图 2 所示。知识推理[15]则是从已知的知识出发,经过推 理挖掘,从中获取所蕴含的新事实,或者对大量 已有知识进行归纳,从个体知识推广到一般性知 识的过程。早期的推理研究大多在逻辑描述与知 识工程领域,很多学者提倡用形式化的方法来描 述客观世界,认为一切推理是基于已有的逻辑知 识,如一阶逻辑和谓词逻辑,如何从已知的命题 和谓词中得出正确的结论一直是研究的重点。近 些年,随着互联网数据规模的爆炸式增长,传统 的基于人工建立知识库的方法不能适应大数据时 代对大量知识的挖掘需求。数据驱动的推理方法 逐渐成为知识推理研究的主流[30]。面向知识图谱的知识推理即在知识图谱的图 结构上,结合概念、属性和关系等知识,通过相 关推理技术,进行知识推理的过程。知识图谱中 所包含的概念、属性和关系天然可用于解释[31-32], 且更符合人类对于解释的认知,方便为真实世界 的推理和解释场景进行直观建模,因此当前基于 知识图谱的知识推理方法成为知识推理领域的典 型代表。下文中的“知识推理”如未加特别说明, 特指“面向知识图谱的知识推理”。 知识图谱推理任务主要包括知识图谱补全和 知识图谱去噪。前者是通过推断出新的事实,扩 充知识图谱,包括实体预测、关系预测、属性预 测等任务。其中最为核心的任务是实体预测和关 系预测,实体预测是指利用给定的头实体和关系 (或者关系和尾实体)找出有效三元组的尾实体 (头实体);关系预测是指通过给定头实体和尾实 体,推理出两者间的关系。后者关注图谱中已知 的知识,对于已经构建的图谱中三元组的正误进 行评判,但从本质上来讲,两者其实是在评估三 元组的有效性。除此之外,知识推理在下游的信 息检索、智能问答和推荐系统中也发挥着重要的 作用,在智慧医疗、网络与信息安全等领域显现 出良好的应用场景[27-28]。知识推理的可解释性或者可解释的知识推理, 是人工智能可解释性的子问题[33]。与研究深度学习 算法的可解释性不同,可解释知识推理的目的是从 已知的知识出发,经过可解释的推理方法,最终获 取知识库中蕴含的新知识。目前基于知识图谱的可解释知识推理是该领域前沿的研究方向之一,其在 可解释知识推理上有诸多优势,具体如下。首先,知识图谱在表示模式上具有可解释优 势。知识表示是为描述世界所做的一组约定,是 知识的符号化、形式化或模型化的过程。常见的 知识表示方法包括谓词逻辑表示法、产生式表示 法和分布式知识表示法等,作为一种新型的知识 表示方法,相对于这些传统的知识表示方法,如 产生式表示法,知识图谱具有语义丰富、结构友 好、知识组织结构易于理解的优点。 其次,基于知识图谱的推理在推理过程中具 有可解释的优势。人类认识世界、理解事物的过 程,大多是在利用概念、属性、关系进行理解和 认知,如对于问题“为什么鸟儿会飞?”,人类的 解释可能是“鸟儿有翅膀”,这实质上使用了属性 来解释。知识图谱中富含实体、概念、属性、关 系等信息,通过图结构形式化组织这些海量的知 识,为真实世界的各个推理场景直观建模,可以 对最终的决策进行更多元的具体解释。 最后,知识图谱在存储和使用上具有可解释 的优势,相比其他的存储形式,知识图谱以三元 组的形式对知识进行构建以及存储,更加接近人 类通常认识事物“主谓宾”的认知和学习习惯, 对于人类理解会更加友好,对人们的可解释性相 比其他知识表示方法较强[19]。根据模型产生的可解释性范围,可解释性分 为局部可解释和全局可解释,即解释是面向某个 或某类实例还是面向整个模型行为。 根据模型解释产生的方法,推理模型可以分 为事前可解释和事后可解释。其中,事前可解释 主要指不需要额外辅助的解释方法,解释本身就 在自身的模型架构中,而事后可解释指解释本身 不在模型架构中,而是在模型训练后,以人类可 理解的规则或可视化等方式,对模型做出决策的 逻辑过程进行后验的解释。(3)可解释的泛化性 根据解释方法是否特定于模型,可以划分为 特定于模型和与模型无关两种解释类别。 (4)可解释在下游场景的适用性 根据下游实际业务需求对于知识推理方 法的可解释性的要求,可以将推理方法分为适 用于可靠性优先领域(如医疗、网络与信息安 全领域)和适用于效率优先领域(如电影推荐 系统)。本文在接下来综述方法时,每类方法 根据以上 4 种评价指标对模型的可解释性进行 对比分析。本文采用的知识推理的准确性评价指标包括 平均倒数排名(MRR,mean reciprocal rank)和 前 k 次命中正确预测结果的比例(Hit@k)。推动人工智能发展的 3 种主要研究范式(符 号主义、行为主义和连接主义),对知识图谱推理 方法都有着很大的影响,但三者在研究方法和技 术路线等方面有着不同的观点,导致不同研究范 式影响下的知识推理方法在可解释性与效率上存 在不同的侧重,所适用的应用场景有所差异。如 图 3 所示,本文从这 3 种研究范式角度出发,结 合目前新型混合的知识图谱推理技术,分别综述 这些分类中最新的可解释知识图谱推理方法研究 进展。从符号主义角度,知识推理可以建模为依据 符号表征的一系列明确推论,通过显式的定义推 理所需要的本体概念、规则等离散符号,进行逻 辑推理的过程。其核心是从实例中推导出一般的 本体演绎关系或逻辑规则,通过符号体系进行推理,同时,这些符号体系为推理结果提供显式的 解释。根据知识图谱本体概念层和实体实例层的 划分,符号推理方法可以分为基于本体的知识推 理和基于逻辑规则的知识推理,接下来分别介绍 其中有代表性的可解释知识推理方法。从行为主义角度,知识图谱推理可以建模为 在图结构上通过多步游走,同时对每一步进行预 见和控制,通过序列决策逐步找到推理答案的过 程,其核心是实现知识图谱图结构上的多跳推理。该类方法在得到推理结果的同时,显式地推导出 具体的路径推导过程,因此可解释性较强。该研究领域有两个主要方向,分别是基于随 机游走和基于强化学习的知识图谱推理方法。基 于随机游走的知识图谱推理方法在图结构上利用 随机游走策略,结合合适的图搜索算法获取多条 路径,利用这些路径的特征预测实体间是否存在 潜在的关系;基于强化学习的知识图谱推理方法 则通过智能体与环境不断进行交互,以反馈和交 互的方式训练智能体,在动作选择和状态更新的 动态过程中逐渐优化目标,进而实现知识推理。从连接主义角度,知识图谱中的实体和关系 可以通过表示学习方法嵌入低维向量空间,进行 数值化的运算操作,进而实现知识推理。其核心是找到一种映射函数,将符号表示映射到向量空 间进行数值表示,从而减少维数灾难,同时捕捉 实体和关系之间的隐式关联,实现符号表示向量 化的直接计算。在语义的层面,很多浅层的表示模型在提升 效率的同时,考虑建模不同的关系模式(如对称 关系、逆反关系和组合关系)、逻辑操作(如与、 或、非操作)和实体间的上下位层次关系,使模 型具有推理部分语义结构的能力,因此,连接主 义中的部分推理模型具有一定的可解释性。该类 方法大体可以分为 3 种,分别是基于平移距离的 模型、基于张量分解的模型和基于神经网络的模 型,本文重点对方法的可解释性进行对比分析。主流的挖掘隐式特征的嵌入学习模型 (TransE[87]、RotatE[91]等),提升了模型的推理效 率,但极大地影响了模型的可解释性。基于图遍 历搜索的显式逻辑规则挖掘方法(AMIE+[52]、 RDF2Rule[53]等)在提升推理过程可解释性的同 时,效率方面有明显的欠缺。因此,通过结合两 者的优势,利用符号推理在可解释性和准确性上 的优势以及神经网络方法在鲁棒性与效率上的优 势,进行混合推理[113],可以一定程度解决传统规 则方法的计算复杂度高等难题,同时提升神经网 络方法的可解释性。根据推理的不同侧重点,可 以将新型的混合推理方法分为符号规则增强神经 网络的知识推理和神经网络增强符号规则的知识 推理。随着人工智能技术的广泛应用,人工智能的 可解释性受到越来越多的关注。在目前流行的深 度学习模型中,复杂的处理机制与大量的参数使 人类很难追溯与理解其推理过程,导致这种端到 端的黑箱学习方法可解释性较差。知识图谱作为知识的一种语义化和结构化的表达方式,以人类 可理解的表达形式进行知识推理,通过推理路径、 逻辑规则等辅助手段,结合节点周围的实体信息, 进行显式的可解释知识图谱推理,为实现可解释 人工智能提供了一种解决方案,在信息检索、信 息安全、网络空间安全等领域都有广泛的应用前 景,引发了广泛的关注。 本文概述了可解释人工智能及知识推理的相 关概念,从经典的人工智能三大研究范式的角度 出发,总结和分析了可解释的知识推理方法。无 论是以符号主义中的本体推理和规则推理方法为 代表的具有全局模型可解释性的模型,还是通过 将推理过程显式地进行学习(具体表现为证明、 关系路径和逻辑规则等方式),从而为推理预测提 供可解释性依据的具有事后过程可解释性的模 型,都一定程度增强了人们对推理结果的理解, 同时实现对错误预测原因的辅助挖掘。如表 7 所示,本文对所介绍的知识图谱推理 方法及特点进行相关的总结与对比分析。这些推 理方法根据推理目的不同,在推理准确性和可解 释性方面各有侧重,所适用的推理应用场景也因 此不同。符号主义中的知识推理模型有着很好的 可解释性,推理准确、迁移性好。然而,离散的 符号表示方法通常不足以描述数据之间所有内在 关系,造成规则学习的搜索空间太大、效率较低, 且对数据中出现的噪声鲁棒性较差(如 AMIE+[52]、RDF2Rule[53]),因此这种推理方法适 用于数据库知识结构规整,要求推理精度及可解 释程度较高的推理场景,如医疗和信息安全等要 求可靠性优先的领域。在行为主义中的知识推理 模型中,以强化学习为代表,通过反馈和交互训 练智能体,鼓励获得更大的奖励,实现了较高的 推理效率,同时得到具体的推理路径,可解释性 虽然相较于逻辑规则有所降低,但得到了具体的 推理步骤,具有过程的可解释性(如 DeepPath[73]、 MINERVA[74]),因此这种推理方法更适用针对序 列决策问题的多跳知识推理场景,如网络安全领 域的攻击路径推理图谱,推理效率和可解释性均 有较大的优势。在连接主义中的知识推理模型中, 通过数值化运算实现的模糊推理,加快了推理的速度,增强了模型的鲁棒性和推理效率,但不能 为预测结果提供显式的推理过程说明,对模型的 可解释性造成了很大影响(如 TransE[87] 、 RotatE[91]),凭借其效率和鲁棒性的优势,这种推 理方法适用在低风险但效率要求较高的效率优先 领域,如电影推荐系统与问答系统等。在新型混 合的推理模型中,结合符号推理在可解释性上的 优势和神经网络推理在鲁棒性与效率上的优势进 行的新型混合推理,无论是利用逻辑规则生成更 多实例,辅助高质量嵌入学习,还是通过神经网 络模型辅助解决数据的歧义和不确定性,帮助归 纳出更多的显式逻辑规则,推理的可解释性和效 率都得到了提升(如 IterE[117]、RNNLogic[140]), 这种推理方法则更加需要结合系统及应用需求, 根据目标任务要求的效率或可解释性等指标的不 同,动态调整对应神经网络推理方法和符号推理 方法的侧重点,有针对性地进行推理。虽然目前可解释的知识图谱推理方法在不同 的研究范式下都取得了一定进展,但该领域仍处 于发展时期,各类方法在推理的准确性和推理过 程的可解释性上很难达到平衡,需要在理论和实 际应用中进一步完善,在未来的研究中,可解释 的知识推理还面临很多新的挑战,主要有以下 4 个 方面值得探索。 1) 结合常识知识的可解释推理。常识推理即 利用人类对世界和行为基本理解的常识认知进行 推理。结合目前人类在深度学习方面的进展,表征并融入常识知识于推理模型,从而创造更加贴 近人类思维习惯的模型,将从本质上增加模型行 为的透明度,帮助人们获得更具可解释性的结果。 2) 考虑复杂推理模式的可解释知识推理。在 知识逻辑推理中,推理的规则主要遵循传递性约 束,即链状的推理,表达能力有限。但是现实生 活中所要面临的要素更加复杂,需要支持更复杂 推理模式,自适应地挖掘更多样、有效的推理结构, 如实现对树状或网状等结构的逻辑规则推理[130], 同时保证挖掘规则的可靠性和可解释性,辅助更 多样的决策。 3) 多模态的可解释知识推理。解释方法大多 通过推理文本中的逻辑规则或路径从而实现可解 释性,但随着移动通信技术的快速发展,如何有 效地利用语音、图片等多模态信息进行解释成为 一个具有挑战性的问题[141]。多模态信息显示出其 对知识图谱进行可解释推理的潜力,可以通过图 像、声音等多种模态对于推理的过程与结果进行 语义增强的解释。 4) 可解释性的量化度量指标。对于可解释性 的优劣并不存在非常成熟的、广为接受的量化标 准。大多数已有的方法是主观度量,因而只能定 性分析,无法对可解释模型的性能进行量化。这就造成用户无法非常准确地判断解释方法的 优劣[142],所以需要进一步研究科学合理的可解释 的评测指标,对解释方法进行量化评价,模型 得到反馈并进行相关优化,从而更好地指导系 统的决策。未来智能实验室的主要工作包括:建立AI智能系统智商评测体系,开展世界人工智能智商评测;开展互联网(城市)大脑研究计划,构建互联网(城市)大脑技术和企业图谱,为提升企业,行业与城市的智能水平服务。每日推荐范围未来科技发展趋势的学习型文章。目前线上平台已收藏上千篇精华前沿科技文章和报告。

如果您对实验室的研究感兴趣,欢迎加入未来智能实验室线上平台。扫描以下二维码或点击本文左下角“阅读原文”

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号

人工智能学家

人工智能学家