理论计算机科学家 Boaz Barak:深度学习并非“简单的统计”,二者距离已越来越远

场景A:拟合统计模型

的得到形式是

的得到形式是 ,其中

,其中 是对应的噪声,为简单起见使用了加性噪声,而

是对应的噪声,为简单起见使用了加性噪声,而 是正确的真实标签。)

是正确的真实标签。) 拟合到数据中,使

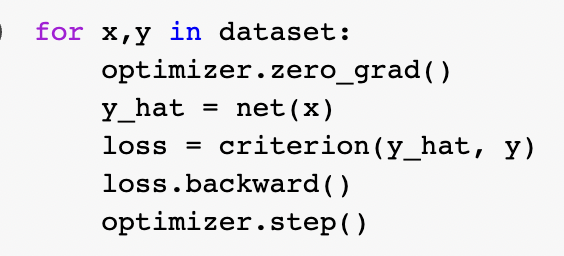

拟合到数据中,使 的经验风险最小。也就是说,我们使用优化算法来找到

的经验风险最小。也就是说,我们使用优化算法来找到 的最小化数量

的最小化数量 ,其中

,其中 是一个损失项(捕捉

是一个损失项(捕捉 距离 y 有多近),

距离 y 有多近), 是一个可选的规范化项 (试图使得

是一个可选的规范化项 (试图使得 偏向更简单的模型)。

偏向更简单的模型)。 很小(这种预测是基于实验数据所在的总体数据来获得的)。

很小(这种预测是基于实验数据所在的总体数据来获得的)。

来实现。F 的类越大,偏差越小,当

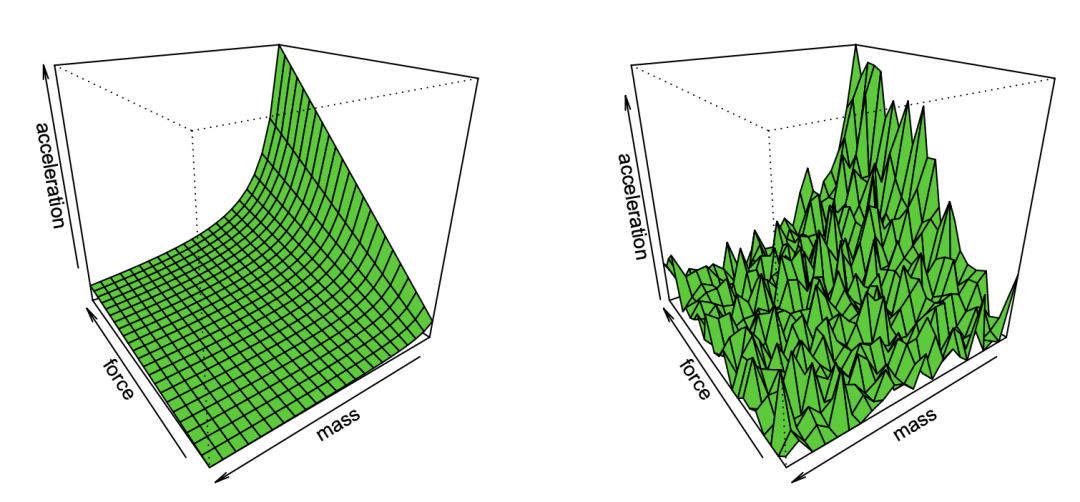

来实现。F 的类越大,偏差越小,当 ,偏差甚至可以是零。然而,当 F 类越大, 则需要越多样本来缩小其成员范围,从而算法输出模型中的方差就越大。总体泛化误差是偏差项和方差贡献的总和。

,偏差甚至可以是零。然而,当 F 类越大, 则需要越多样本来缩小其成员范围,从而算法输出模型中的方差就越大。总体泛化误差是偏差项和方差贡献的总和。 和

和 ),比独立学习单个更难。

),比独立学习单个更难。 ,其所需的数据点数量在某些参数 k 下以

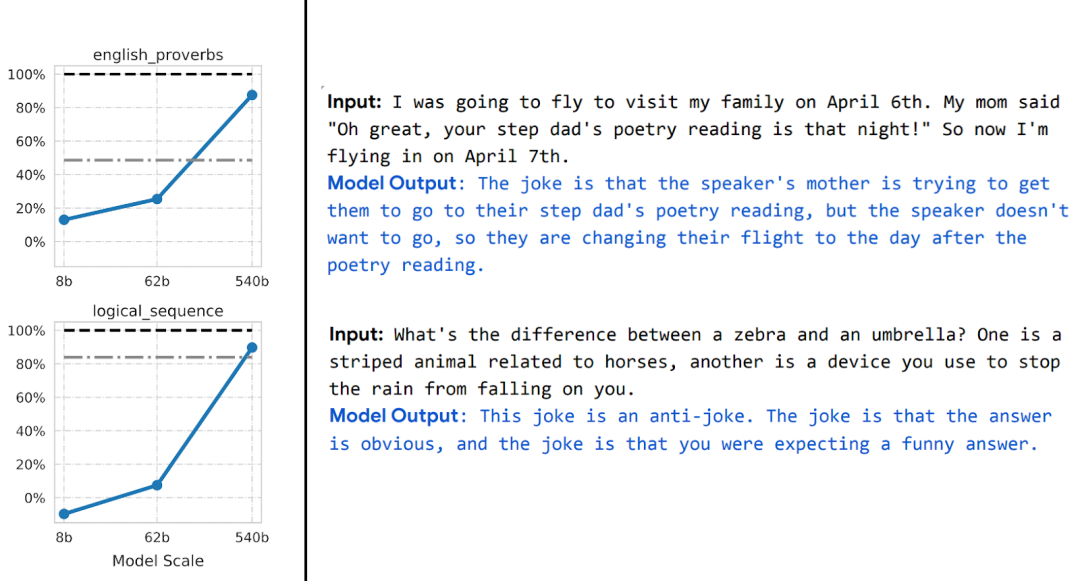

,其所需的数据点数量在某些参数 k 下以 的形式拓展。在这种情况下,需要大约 k 个样本来“起飞”,而一旦这样做,则会面临收益递减的制度,即假设花耗 n 个点来达到(比如)90%的准确度,那么想要将准确度提高到95%,则大约需要另外 3n 个点。一般来说,随着资源增加(无论是数据、模型的复杂性,还是计算),我们希望捕捉到更多更细的区别,而不是解锁新的质量上的能力。

的形式拓展。在这种情况下,需要大约 k 个样本来“起飞”,而一旦这样做,则会面临收益递减的制度,即假设花耗 n 个点来达到(比如)90%的准确度,那么想要将准确度提高到95%,则大约需要另外 3n 个点。一般来说,随着资源增加(无论是数据、模型的复杂性,还是计算),我们希望捕捉到更多更细的区别,而不是解锁新的质量上的能力。场景B:学习数学

,其中

,其中 是某个数据点(例如具体的图像)、

是某个数据点(例如具体的图像)、 是一个标签。

是一个标签。 ,这个函数的训练只使用数据点

,这个函数的训练只使用数据点 而不使用标签,通过最小化某种类型的自监督损失函数。这种损失函数的例子是重建或画中画(从另一个输入 x 的某些部分恢复)或对比学习(找到

而不使用标签,通过最小化某种类型的自监督损失函数。这种损失函数的例子是重建或画中画(从另一个输入 x 的某些部分恢复)或对比学习(找到 使

使 显著更小,当

显著更小,当 是同一个数据点的增量时,并列关系比两个随机点的并列关系要小得多)。

是同一个数据点的增量时,并列关系比两个随机点的并列关系要小得多)。 来拟合线性分类器

来拟合线性分类器 (其中 C 是类的数量),使交叉熵损失最小。最终的分类器得出了

(其中 C 是类的数量),使交叉熵损失最小。最终的分类器得出了 的映射。

的映射。

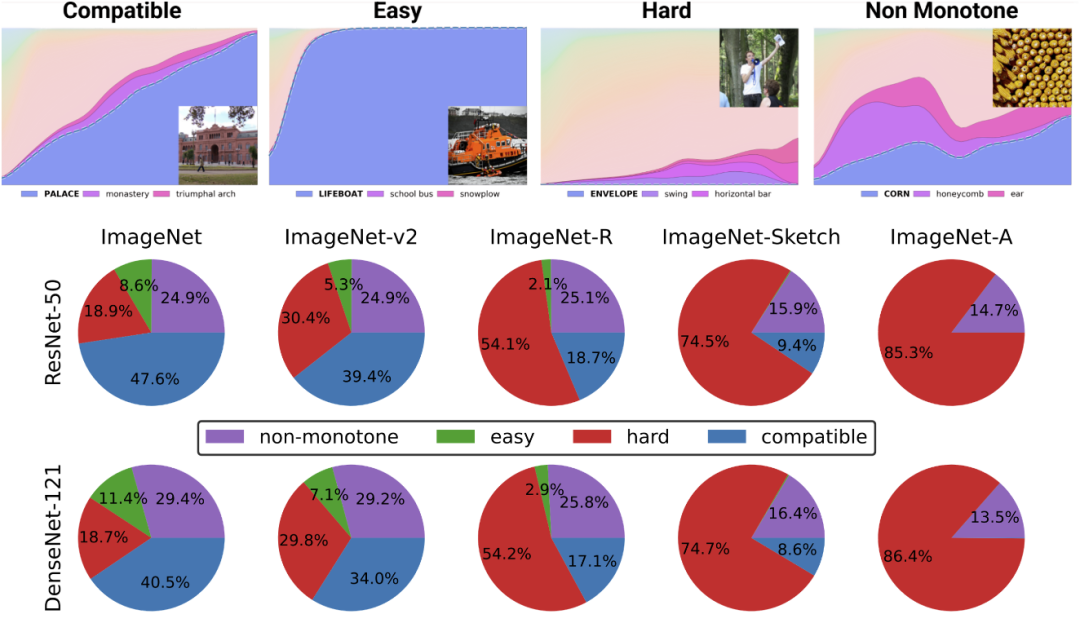

情况1:监督学习

,都可以将通过自监督训练的深度 d 模型的首 k 层数与监督模型的最后 d-k 层数“缝合”起来,并且使性能几乎保持原有水平。

,都可以将通过自监督训练的深度 d 模型的首 k 层数与监督模型的最后 d-k 层数“缝合”起来,并且使性能几乎保持原有水平。

情况2:过度参数化

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

赞助链接

排名

热点

搜索指数

- 1 习近平同马克龙交流互动的经典瞬间 7904716

- 2 黑龙江水库冰面下现13匹冰冻马 7808146

- 3 微信表情包戒烟再度翻红 7714597

- 4 2025你的消费习惯“更新”了吗 7619522

- 5 三星堆与秦始皇帝陵竟有联系 7522812

- 6 为啥今年流感如此厉害 7426182

- 7 劲酒如何成了年轻女性的神仙水 7327534

- 8 一身塑料过冬?聚酯纤维真是塑料瓶吗 7238870

- 9 15岁高中生网购日军侵华史料捐出 7136279

- 10 中疾控流感防治七问七答 7040697

大数据文摘

大数据文摘