SIGIR 2022|邻域建模Graph-Masked Transformer提高微信视频点击率预测

机器之心专栏

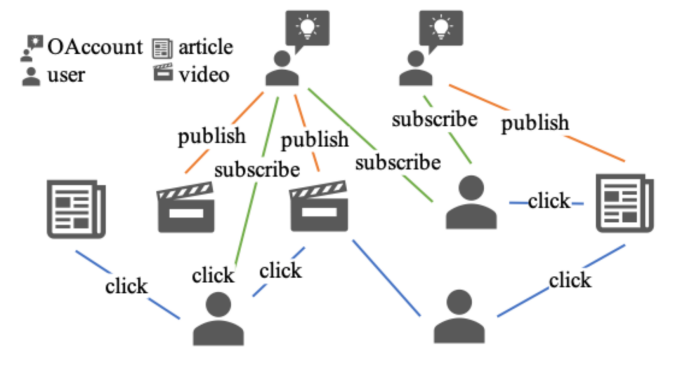

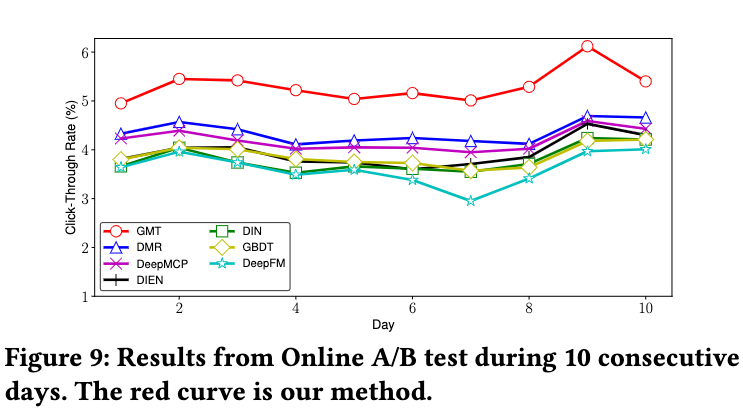

本文介绍的是腾讯 AI Lab 和微信公众平台共同研发的一种最新的在异质图上基于邻域交互的点击预测新模型。论文题目为《Neighbour Interaction based Click-Through Rate Prediction via Graph-masked Transformer》,论文已被 SIGIR2022 录用。并且在实际线上场景部署 A/B 测试中获得很好的效果。

,为了能够扩展对用户点击偏好的描述,我们在这一异构图上采样一个和

,为了能够扩展对用户点击偏好的描述,我们在这一异构图上采样一个和 相关的一个邻域节点集合

相关的一个邻域节点集合 以及对应的子图

以及对应的子图 ,并且将点击率预测这一问题转化为对这一邻域分类问题。

,并且将点击率预测这一问题转化为对这一邻域分类问题。

? , 一组 N 物品?

? , 一组 N 物品? 。用户与项目的相互作用被表示为一个矩阵

。用户与项目的相互作用被表示为一个矩阵 , 其中?

, 其中? 表示用户 u 之前点击了项目 v , 否则?

表示用户 u 之前点击了项目 v , 否则? 。给出任务相关的

。给出任务相关的 , 如第 2.3.2 节所述, 我们可以为每个候选用户?u 和 项目 v 对抽取一批邻近节点

, 如第 2.3.2 节所述, 我们可以为每个候选用户?u 和 项目 v 对抽取一批邻近节点 ?。每个节点?

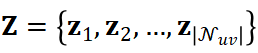

?。每个节点? 都与一个特征向量相关联, 如第 2.3.1 章节所述, 因此我们将采样的?

都与一个特征向量相关联, 如第 2.3.1 章节所述, 因此我们将采样的? 的特征向量集表示为?

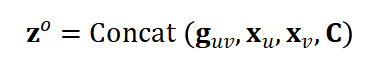

的特征向量集表示为? 。此外, 我们将背景特征(如时间、匹配方法、匹配得分)表示为 C 。因此, 一个

。此外, 我们将背景特征(如时间、匹配方法、匹配得分)表示为 C 。因此, 一个 实例可以表示为:

实例可以表示为:

和背景特征 C 预测用户 u 点击物品 v 的概率。

和背景特征 C 预测用户 u 点击物品 v 的概率。

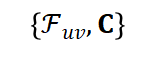

采样。

采样。 集合采样

集合采样 采样得到其邻域集合

采样得到其邻域集合 。

。

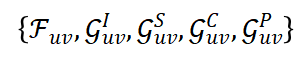

节点交互的可能性。具体的,我们构建了四种不同交互图:

节点交互的可能性。具体的,我们构建了四种不同交互图: :用于建模自然交互的导出子图,代表了原始异构图上的交互信息。

:用于建模自然交互的导出子图,代表了原始异构图上的交互信息。 :用于建模节点特征相似性图,代表了节点特征层面的交互信息,通过特性相似性, 可以捕捉到节点特征层面的语义信息。

:用于建模节点特征相似性图,代表了节点特征层面的交互信息,通过特性相似性, 可以捕捉到节点特征层面的语义信息。 :用于捕捉用户邻域和物品邻域间交互的交叉邻域二分图,代表了用户和物品的邻域的节点之间可能的交互信息。

:用于捕捉用户邻域和物品邻域间交互的交叉邻域二分图,代表了用户和物品的邻域的节点之间可能的交互信息。 :用于建模邻域中任何节点间交互的完全图。代表了任何两个节点之间可能的交互信息。

:用于建模邻域中任何节点间交互的完全图。代表了任何两个节点之间可能的交互信息。

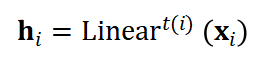

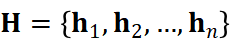

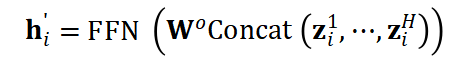

中的节点 i, 由于不同类型的节点具有不同的特征维度, 因此具有不同的特征空间,这里,为了能够统一处理异质节点的情况,我们使用类型感知的特征转换层将它们嵌入到一个统一的空间:

中的节点 i, 由于不同类型的节点具有不同的特征维度, 因此具有不同的特征空间,这里,为了能够统一处理异质节点的情况,我们使用类型感知的特征转换层将它们嵌入到一个统一的空间:

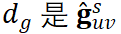

是第?i 个节点的类型, 而?

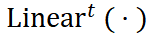

是第?i 个节点的类型, 而? 是第 t 类节点类型的线性层, 不同类型的节点具有不同的可学习参数。

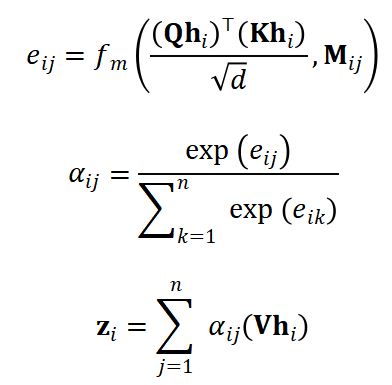

是第 t 类节点类型的线性层, 不同类型的节点具有不同的可学习参数。 ,和的交互图邻接矩阵 M,我们定义了 Masked Attention:

,和的交互图邻接矩阵 M,我们定义了 Masked Attention:

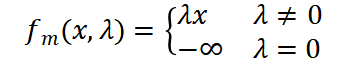

为掩码函数:

为掩码函数:

。

。

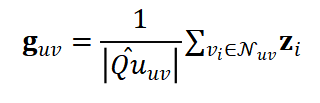

的邻域表示

的邻域表示 后。为了突出两个目标节点的本身特征, 我们将它们的初始稠密嵌入?

后。为了突出两个目标节点的本身特征, 我们将它们的初始稠密嵌入? 与邻域表示?

与邻域表示? 和上下文特征 C 串联起来。因此, 数据实例的最终嵌入是:

和上下文特征 C 串联起来。因此, 数据实例的最终嵌入是:

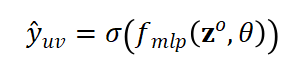

的 MLP 层?

的 MLP 层? 和一个 Sigmoid 函数?

和一个 Sigmoid 函数? 来预测用户 u 会点击目标物品 v 的概率:

来预测用户 u 会点击目标物品 v 的概率:

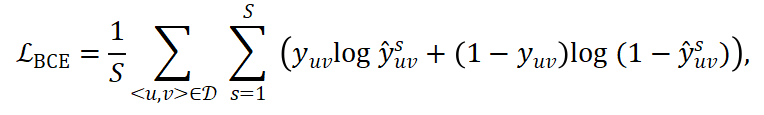

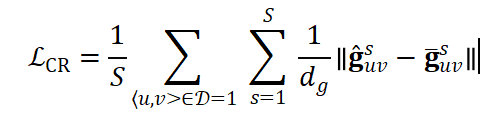

对,因为每次从 HIN 采样得到的邻域信息

对,因为每次从 HIN 采样得到的邻域信息 都不相同,为了使得训练未定,在对

都不相同,为了使得训练未定,在对 进行 S 次采样得到

进行 S 次采样得到 的预测平均作来作交叉熵损失:

的预测平均作来作交叉熵损失:

是训练集,??

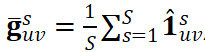

是训练集,?? 是点击的真实标签。同时为了提升模型训练稳定性,我们采用了一个一致性正则化项的变体来强制使得对同一

是点击的真实标签。同时为了提升模型训练稳定性,我们采用了一个一致性正则化项的变体来强制使得对同一 对采样学到的表示尽可能一致:

对采样学到的表示尽可能一致:

, 而

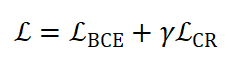

, 而 的维度。最终训练的损失函数为:

的维度。最终训练的损失函数为:

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

赞助链接

排名

热点

搜索指数

- 1 确保“十五五”开好局起好步 7904418

- 2 多所高校定制羽绒服卖爆 7809460

- 3 故宫下雪了 7712831

- 4 2026年经济工作要这么干 7619281

- 5 感觉时间越来越快不是错觉 7524330

- 6 员工“踢了一脚” 救了老板一命 7428061

- 7 演员印小天在景区救下落水女子 7328038

- 8 不提“雪” 怎么描写雪很大 7233376

- 9 茅台价格跌破1499元 7138575

- 10 中央经济工作会议释放哪些重要信号 7044555

机器之心

机器之心