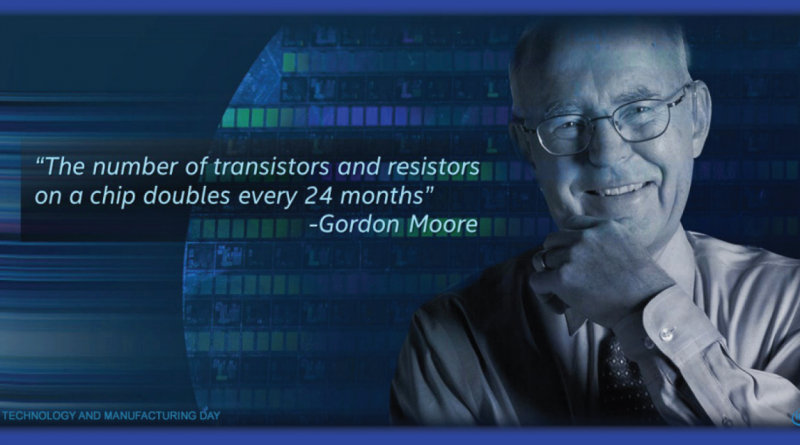

5300亿!巨型语言模型参数每年暴涨10倍,新「摩尔定律」要来了?

新智元报道

【新智元导读】近年来,大型语言模型参数量每年暴增10倍,最近的巨无霸模型MT-NLG,参数更是达到了5300亿!关于模型参数的「新摩尔定律」已呼之欲出。不过,这可不一定是好事。

大脑的深度学习

研究人员估计,人类大脑平均包含860亿个神经元和100万亿个突触。但不是所有的都用于语言。有趣的是,GPT-4预计将有大约100万亿个参数。

这会是一个巧合吗?我们不禁思考,建立与人脑大小差不多的语言模型是否是一个长期可行的方法?

是深度学习,还是「深度钱包」?

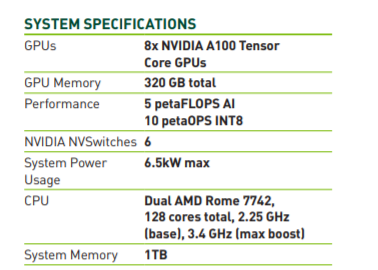

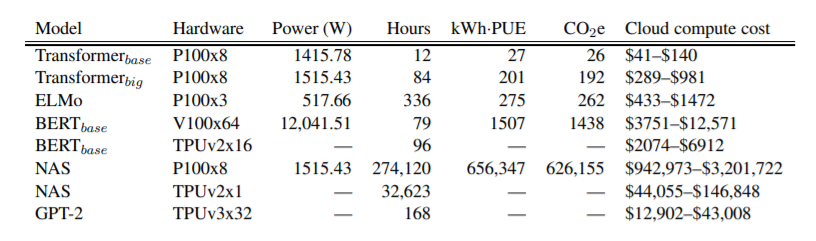

在庞大的文本数据集上训练一个5300亿个参数模型,无疑需要庞大的基础设施。

GPU集群:散热、环保都成问题

实际上,在GPU上训练深度学习模型是一项十分费力的事情。

使用预训练模型

绝大多数情况下,并不需要定制模型体系结构。

使用小模型

微调模型

需要收集、存储、清理和注释的数据更少

实验和数据迭代的速度更快

获得产出所需的资源更少

使用云基础设施

优化模型

从编译器到虚拟机,软件工程师长期以来一直使用工具来自动优化硬件代码。

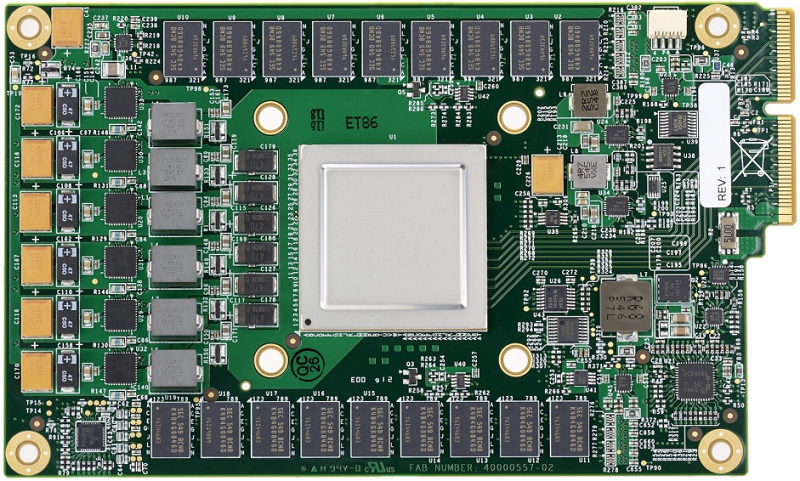

硬件:大量面向加速训练任务(Graphcore、Habana)和推理任务(Google TPU、AWS Inferentia)的专用硬件。

剪枝:删除对预测结果影响很小或没有影响的模型参数。

融合:合并模型层(比如卷积和激活)。

量化:以较小的值存储模型参数(比如使用8位存储,而不是32位存储)

另一个「摩尔定律」要来了吗?

参考链接:

https://huggingface.co/blog/large-language-models

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

赞助链接

排名

热点

搜索指数

- 1 中法元首相会都江堰 7904463

- 2 中方不接受日方所谓交涉 已当场驳回 7807916

- 3 大闸蟹为何会在欧美泛滥成灾 7712798

- 4 国际机构看中国经济 关键词亮了 7618372

- 5 家长称婴儿被褥印不雅英文单词 7521838

- 6 日方军机滋扰擅闯或被视为训练靶标 7425872

- 7 12306出新功能了 7328063

- 8 国乒8比1击败日本队 11战全胜夺冠 7232454

- 9 男子海洋馆内抽烟被白鲸喷水浇灭 7136164

- 10 千吨级“巨无霸”就位 7041731

新智元

新智元