TiDB 5.2 发版 ——“交易+分析”双引擎提速,挑战极限业务场景

作为数字化新时代的企业级数据库, TiDB 基于海量数据规模的在线事务处理和实时分析能力在全球金融、互联网、物流、零售、在线游戏等各个行业得到充分验证,并广受好评。今年 4 月 ,TiDB 发布针对企业级的里程碑 5.0 版本,并在 6 月份发布了 5.1 版本,目前已经应用在数十家大型企业的生产环境。?

TiDB 5.2 聚焦于用户真实场景,挑战更为严苛的超大规模 OLTP 和实时数据分析的性能极限,进一步拓展了“交易+分析”双引擎数据处理能力的边界。测试结果表明,无论是高负载大集群场景还是高吞吐写入的并发实时分析场景,TiDB 5.2?均表现出了更优异的稳定性、更出色的实时性、更佳的易用性,可以更轻松地加速企业实现数字化转型和数据价值变现。

TiDB 5.2 功能亮点和用户价值

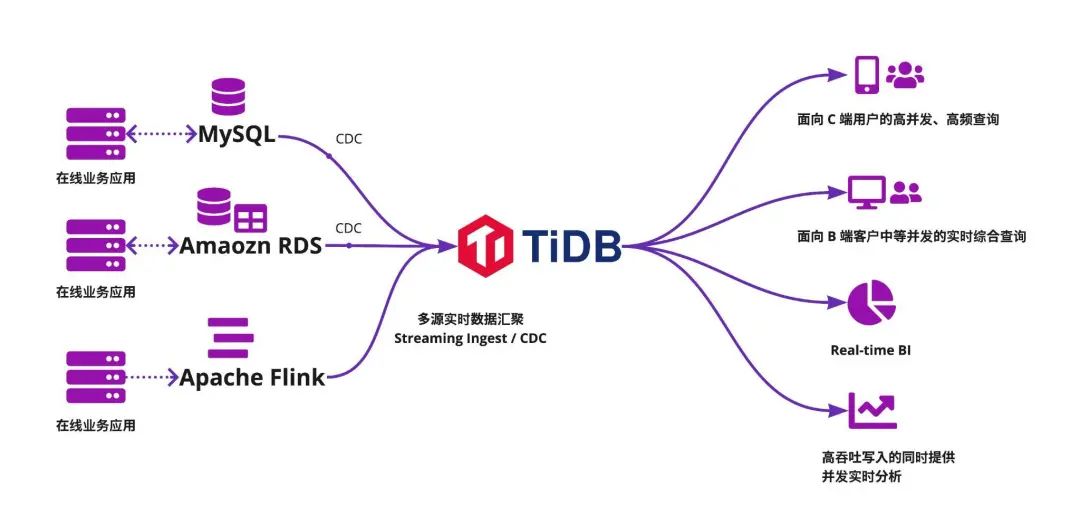

在这种情况下,企业可以将数据实时汇聚到可无限水平扩展并兼容 MySQL 的 TiDB,由 TiDB 直接对接数据应用端。数据汇聚到 TiDB 后,无论是处理面向 C 端或 B 端客户的 OLTP 请求(例如,电商平台的 C 端和 B 端请求分别来自买家和卖家,物流平台的 C 端和 B 端请求分别来自寄件人和快递员),还是处理企业后台实时数据服务(例如,Real-time BI、风控、Ad-Hoc 查询),TiDB 都可以提供一站式的数据解决方案,帮助企业打通数据孤岛,既能保证高负载下大集群的查询稳定性和实时性,又能保证高吞吐写入下的并发实时查询和分析的性能与稳定性,并降低企业运维成本。

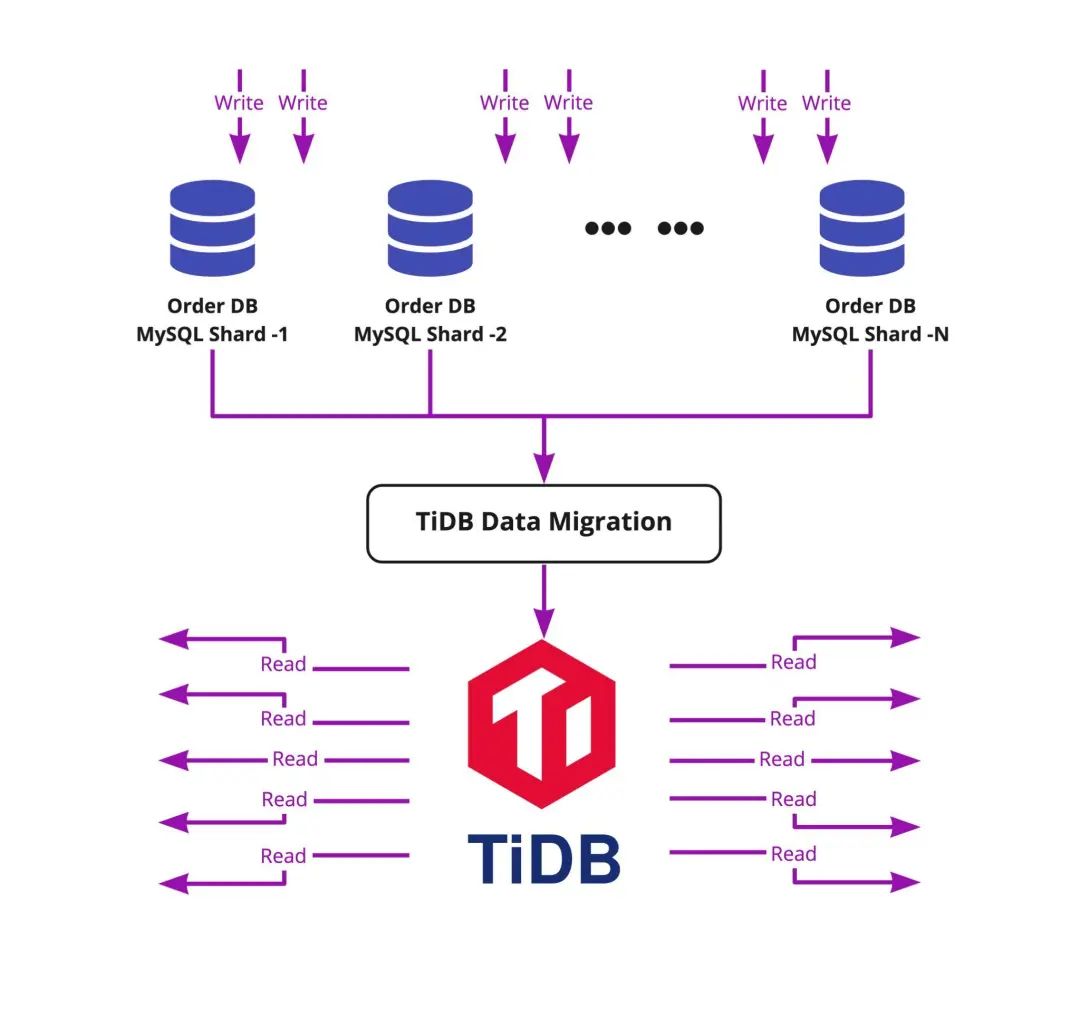

提升大表在高负载写入时在线建索引的速度,优化大流量写入时的内存使用,提升高读写负载压力下大集群的稳定性。 实现 Leader 自动转移,降低单节点性能抖动对整个集群的影响。 升级热点调度策略,有效打散小表热点,并且提供列存引擎 TiFlash 的热点调度能力,实现集群资源的充分利用。 在 200K QPS 压力负载下,DM(TiDB Data Migration)仍可以保证 99% 时间的数据同步延迟在 1s 以内,提高汇聚库的数据更新实时性。

当数据不断更新时,针对统计信息过期或缺失的情况,提升优化器选中正确索引的概率;提升估算模块的准确度,减少人工绑定索引。 当使用 SPM(SQL Plan Management, 执行计划管理)功能自动或人工绑定索引时,用户可以更容易地使用、诊断、调试 SPM 功能。

实现更多的算子下推,更充分地利用 MPP 引擎的能力,降低查询的响应时间。

平稳支持超平时 200%~300% 的峰值写入流量,提供更强大的数据写入支持。 消除了在特殊条件下内部线程互相等待死锁的状况,带来更智能的 MPP 执行引擎,提高分析处理能力。 提升并发能力,可支持 30 量级的并发查询(全表扫描型)稳定执行。

提升高负载下大集群的稳定性,挑战极限业务场景

提升大表在线建索引的速度:在 DDL 过程中合理均衡热点 Region 的 range。 实现 Leader 自动转移:当某个存储节点变慢时,将 Raft 协议中的 leader 角色自动转移到正常的存储节点上以承载业务流量,保证单节点出现性能抖动时集群整体吞吐能力不受影响。 优化 TiKV 的内存使用:严格限制 Raft Log 的 cache 以及 Raft 消息的内存占用,解决了在大流量写入情况下 TiKV 潜在的 OOM 问题。

支持按维度调整热点均衡优先级,提高了对热点场景的处理能力,确保在节点数较多的集群中均衡 CPU 的使用率,避免出现单点瓶颈。在热点小表客户仿真场景中,CPU 资源的均衡度大幅提升,QPS 提升了近一倍。另外也支持对 OLAP 引擎 TiFlash 的热点调度能力,解决了 HTAP 场景的热点调度问题。

减少 DM 资源消耗:DM 2.0.6 以前版本对 CPU 资源消费较多。单 DM 节点的复制流量 1k ~ 3k QPS 下,消耗 35% ~ 50% 的 CPU 资源。为了减少资源的消耗,v2.0.6 版本对多个逻辑点进行了优化,包括 relay log 读写、数据转码优化等。测试结果表明,DM v2.0.6 最多可减少 50% 的 CPU 使用量。 大流量低延迟实时复制:使用 DM 同步 MySQL Shard 上的高负载(聚合后 200K QPS)业务写入数据到 TiDB,DM 可以保持 99% 时间内 1s 实时数据同步延迟。

优化器执行计划更智能,助力电商平台大促卖家订单处理

当优化器生成执行计划所需的统计信息过期或缺失时,TiDB 优化器会先使用启发式规则的方法来对索引进行裁剪和优化,提升选中正确索引的概率。 对优化器的估算模块进行了优化,使更多的查询可由优化器来自动选择正确索引计划,减少人工绑定索引。 当使用 SPM(SQL Plan Management, 执行计划管理)功能自动或人工绑定索引时,用户可以更容易地使用、诊断、调试 SPM 功能: 绑定的查询语句会按照绑定时间戳排序显示,不再是无序显示的结果,方便定位绑定的语句。 支持通过 `EXPLAIN` 语句执行的附加信息获知该 SQL 语句是否使用了绑定。 支持通过设置黑名单定义自动捕获绑定的语句,为用户带来更大的使用灵活性。

轻松应对复杂实时 BI 查询,让业务决策更实时

单并发场景下,简单查询的查询延迟由数十秒降低至不到一秒,复杂查询则是由数分钟降低至一秒左右。 数十并发场景下,简单查询依然可以以不到一秒的延迟响应查询,复杂查询则是从查询超时降低至 10 秒左右。

提升高吞吐写入下的并发实时分析性能和稳定性,助力物流平台备战双十一

更强大的数据写入支持:同规模的集群可以平稳承受 200%~300% 于以往的峰值写入流量,实现“写平衡”,各节点磁盘空间差异在 10% 以内。 更健壮的 MPP 执行引擎:消除了在特殊条件下内部线程互相等待死锁的状况,进一步改善在高负载情况下查询出错或超时取消的问题。 更高的并发支持:在 20~30 并发量级的全表扫描查询,业务查询不出现内存 OOM。在更高的写入流量和并发查询下,出现 OOM 现象可减少 90%以上。 更简单的运维:即使偶发集群不稳定状态(例如节点重启),系统可以自动恢复,或在人工干预下很快恢复。在扩缩容集群时,对客户端的查询响应不会停止,极大地降低了维护 TiFlash 集群时对业务的影响。

结语

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

- 1 中央经济工作会议在北京举行 7904641

- 2 紧急提醒:请在日中国公民进行登记 7808623

- 3 中央定调明年继续“国补” 7713912

- 4 “九天”无人机成功首飞 7617050

- 5 断崖式降温!今冬最强寒潮来了 7522912

- 6 中央经济工作会议释信号:3件事不做 7424538

- 7 中国“空中航母”首飞成功 7327506

- 8 00后女生摆摊卖水培蔬菜日售千元 7234018

- 9 人民空军中日双语发文:大惊小怪 7140421

- 10 寒潮来袭 “速冻”模式如何应对 7043070

PingCAP

PingCAP