来源:arXiv

编辑:Priscilla 好困

【新智元导读】特拉维夫大学和英伟达研究团队利用CLIP模型的语义能力,提出了一种文本驱动的方法:StyleGAN-NADA,无需在新的领域收集图像,只要有文本提示就能极速生成特定领域图像。

GAN应用范围众多,涵盖图像增强、编辑,甚至是分类和回归任务,但在此之前,GAN必须要先收集大量图像。而在实际情况下,一些特定艺术家的画作、虚构场景等,可能没有足够的数据来训练GAN,甚至根本没有任何数据。为解决这一问题,特拉维夫大学和英伟达研究团队利用大规模的对比语言-图像预训练(CLIP)模型的语义能力,提出了一种基于文本的方法:StyleGAN-NADA。不需要在新的领域收集任何一张图像,只需要文本提示就能产生特定领域的图像。论文地址:https://arxiv.org/abs/2108.00946凭借文字提示,经过短时间的训练,就可以让生成器适应不同风格和形状的众多领域。不需要编辑单个图像,使用OpenAI的CLIP信号就可以训练生成器。(高能预警)在框内输入Human和Zombie,马上就能生成对应图像团队的目标是将一个预先训练好的生成器从一个给定的源域转移到一个新的目标域,只使用文本提示,没有目标域的图像。作为目标领域的监督来源,作者只使用一个预先训练好的CLIP模型。(1) 如何才能最好地提炼出CLIP中封装的语义信息?(2) 如何规范优化过程,避免对抗性的解决方案或模式崩溃?

方法的核心是两个利用StyleGAN2架构,相互结合的生成器。两个生成器共享一个映射网络,相同的潜在代码在两个生成器中最初会产生相同的图像。使用在源域图像上预训练的生成器的权重初始化两个交织的生成器--Gfrozen和Gtrain。Gfrozen的权重在整个训练过程中保持固定,而Gtrain的权重则通过优化和迭代的层冻结方案进行修改。这个过程根据用户提供的文本方向转移Gtrain的领域,同时保持一个共享的潜在空间。

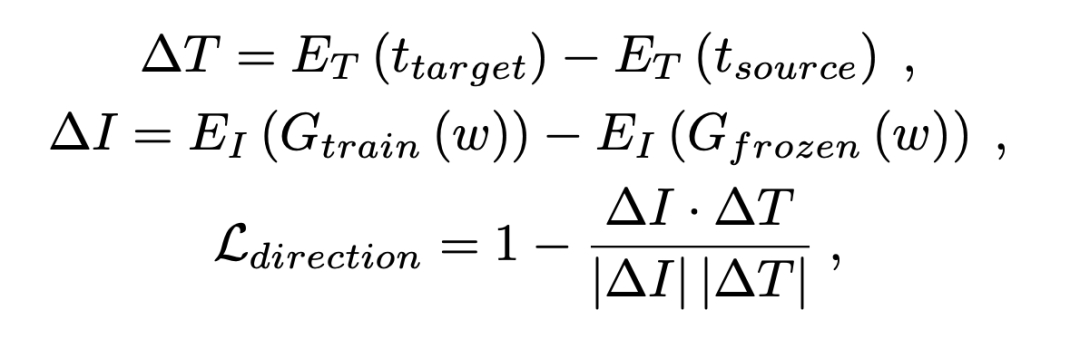

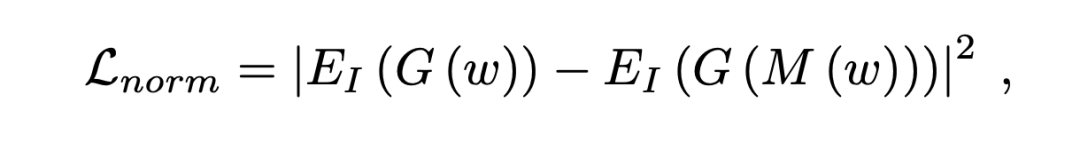

作者依靠一个预先训练好的CLIP模型来作为我们目标领域的唯一监督来源。这种损失旨在使生成的图像和一些给定的目标文本之间的CLIP-空间余弦距离最小。如果正则化不足,该模型便会向图像添加适当的像素级扰动来欺骗CLIP。不过,作者仍然利用它来自适应地确定在每个迭代中训练哪一个层的子集。因此,第二项损失是以保护多样性和阻止广泛的图像损坏为目标设计的。一个由参考(冻结)生成器生成,另一个由修改(可训练)生成器使用相同的潜在代码生成。作者让参考(源)图像和修改(目标)图像嵌入之间的CLIP-空间方向与一对源和目标文本的嵌入之间的CLIP-空间方向保持一致。其中EI和ET分别是CLIP的图像和文本编码器,Gfrozen和Gtrain是冻结的源生成器和修正的可训练生成器,而ttarget和tsource是源和目标类文本。由于全局损失会受到模式崩溃示例的影响,如果目标生成器只创建一个图像,那么从所有来源到这个目标图像的CLIP-空间方向将是不同的。因为想要欺骗CLIP,就必须设计能够应用在无限的实例中的扰动。将两个生成器生成的图像嵌入CLIP空间,并要求连接它们的矢量ΔI与源文本和目标文本规定的方向ΔT共线,并通过最大化它们的归一化内积来实现。在某些情况下,使用StyleCLIP的潜在映射器,可以更好地识别与目标域相匹配的潜在空间区域。然而,映射器会在图像上诱发不希望出现的语义伪影,而这与生成的图像的CLIP-空间嵌入的规范增加有关。因此,通过在映射器训练期间引入一个额外的损失来约束这些规范,从而阻止映射器引入这种伪影。论文提出的方法在广泛的域外图像生成中也适用,从风格和纹理变化到形状修改,从现实到幻想,通过一个基于文本的界面就能实现。就算是最极端的形状变化,只要几分钟的训练也能做到。上图都是由生成器合成的随机采样的图像,目标领域从人脸、教堂、狗到汽车不等。对于纯粹的基于风格的变化,作者允许在所有层进行训练。对于轻微的形状修改,作者发现训练大约三分之二的模型层(即1024×1024模型的12层)在稳定性和训练时间之间提供了一个良好的折衷。与前两张图相比,上图的变化主要集中在风格或轻微的形状调整,这里的模型则需要进行重大的形状修改。现有的预训练生成器只能进行域内编辑,而无法在训练的领域以外生成图像。上图展示了使用三种StyleCLIP以及论文提出的方法向域外文本方向编辑潜代码的结果。可以看到,只有论文提出的模型成功地生成了相应的图像。

参考资料:

https://arxiv.org/abs/2108.00946

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号

新智元

新智元