剧透警告︱哥斯拉 vs. 金刚,谁赢了?

话说前阵子上映的

好莱坞大片

《哥斯拉大战金刚》

可在全国各地

掀起了一波观影浪潮

两个原本在不同

电影世界里的巨兽

突然走到了同一个荧幕

成为本片的一大看点

而电影海报

也很好展现了这种戏剧性

画面里哥斯拉和金刚

互相挥舞拳头

大战一触即发

让人迫切想知道

谁才是真正的怪兽“一哥”

那么,到底谁更厉害呢?

(提示:下文剧透警告)

看过电影的小编表示,金刚被哥斯拉暴打...在第一次交手的时候,哥斯拉被一拳击中只是退了个踉跄,而金刚被打一拳直接倒在地上。到了第三次交手,金刚更是被打得奄奄一息...

其实,这也不能怪金刚太弱,实在是对手太强了...“哥斯拉”的原型是生活在海洋岛屿上的一种蜥蜴,因为人类不加节制地进行核实验,引起了基因突变而变成了怪兽。它不仅有强悍的肉体,还有“原子吐息”这种BUG级别的魔法攻击。

而金刚呢,说到底只是一只长得很大的的猩猩,虽然有人类一般的智慧,但在绝对实力面前,依然只有被碾压的份。

这是不是也从侧面说明基因的重要性呢?

说起基因,今年是第一版人类基因组序列图谱发布20周年。这20年里,基因测序技术的发展势如破竹,为生命科学的研究突破创造了不计其数的科学价值。

当前,基因测序在临床上的应用主要有两类,一类是针对普通人的疾病筛查,通过测定已知的与某种疾病相关的基因序列位点,来推断其未来罹患该种疾病的概率;另一类是针对癌症等致命性疾病的伴随诊断,通过测定某些特定的基因序列位点,在一系列的药物或治疗方案中找到针对特定患者最为有效的药物或方案。

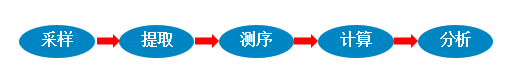

关于基因测序的流程,主要有以下几个步骤:

测序数据分析流程(以全基因组分析为例)如下图:

实验仪器测量数据处理和分析,首先通过实验仪器对生物分子进行测量,使用一些后处理软件对原始的大量数据进行处理和分析。然后对序列数据进行同源及相似性搜寻、比对、序列分析、遗传发育分析等。

基因测序技术应用需要对海量、复杂、多变的数据进行分析计算,因此对高性能计算机的计算性能、内存容量、数据带宽等要求很高,同时还必须支持完善的基因测序分析工作流。

在短短十几年间,基因测序技术已经形成了多个研究方向,其中与高性能计算相关的主要研究重点如下:

序列比对(SequenceAlignment)的基本问题是比较两个或两个以上符号序列的相似性或不相似性。在序列对比的过程中,将会产生巨量的数据,这对我们的存储系统带来了较大规模的挑战,如下图:

可以看出,现在用于存储的硬盘容量每14个月会有一倍的增长,而基因序列的数据量则每5月左右会翻一番。

序列拼接是将测序生成的reads短片段拼接起来,恢复出原始的序列。该问题是序列分析的最基本任务,是基因组研究成功与失败的关键,拼接结果直接影响到序列标注,基因预测、基因组比较等后续任务。

基因组序列的拼接也是基因组研究必须解决的首要难题。其困难不仅来自它的海量数据(以人类基因组序列为例,从数量为10兆级的片断恢复出长度为亿级的原始序列),而且源于它含有高度重复的序列。

从计算机方面来讲,在拼接初期,会有大量的初始数据导入内存,然后对这些数据进行处理。因此,序列拼接对于计算机的内存量和计算能力都有非常大的需求。

根据以上基因测序软件的普遍特点,戴尔科技给出了如下的集群配置建议:

(1)基因比对、拼接等计算非浮点密集型计算应用,CPU利用率、idle%呈现规律性交替变化,并且程序起始阶段CPU利用率低,主要进行I/O处理,高主频可加快进度,双路节点配置建议选用戴尔科技新一代PowerEdge服务器平台,提供最苛刻工作负载和卓越性能。

(2)内存带宽随CPU利用率交替变化并且峰值并不高,内存容量需求较大,基本上是输入序列大小的5-6倍,单节点搭配8条或16条32GB或64GB内存即可满足中小规模算例需求。

对于大规模的基因拼接、比对计算,内存容量建议配置在2TB以上,PowerEdge R940xs服务器最大可支持6TB内存(单根128GB*48根),可充分保障计算需求。

(3)网络压力较低,仅在读写I/O时涉及到较多网络传输,普通10G或25G以太网即可满足网络带宽需求,选择高速InfiniBand网络也会在一定程度上降低延迟,提升效率。

(4)存储读写压力适中,磁盘读写均呈现阶段性,小规模算例存储读写峰值带宽均在500MB/s以下,选用存储服务器PowerEdge 740xd或740xd2即可满足需求。

中规模算例如人体全基因组比对、拼接等,在程序初始阶段输入文件磁盘读取、计算结果磁盘写阶段对存储的带宽压力会比较大,此时建议选择Dell EMC NFS存储解决方案(NSS),可提供5GB/s以上的带宽,更好地应对存储压力。

Dell EMC NFS存储解决方案(NSS)是一种完全基于NFS的文件存储,提供包括所有必须的硬件、软件、性能指南、支持和部署服务,它实现了功能、性能和可扩展性的完美结合,能够处理大量数据请求,从而支持高达1PB(5U空间84盘位*12TB单盘容量)的原始存储空间。

它由戴尔科技HPC专家采用成熟的戴尔易安信技术进行设计和优化,与未经优化的NFS解决方案相比,吞吐量可提高30%。在下面的案例中,戴尔科技采用最新的硬件设备和xfs,lvm 及lvs等技术,配置包括2台PowerEdge R740服务器,1台PowerVault ME4084存储,可用容量为640TB,以达到7GB/s的读和4.8GB/s写性能。

方案架构图图

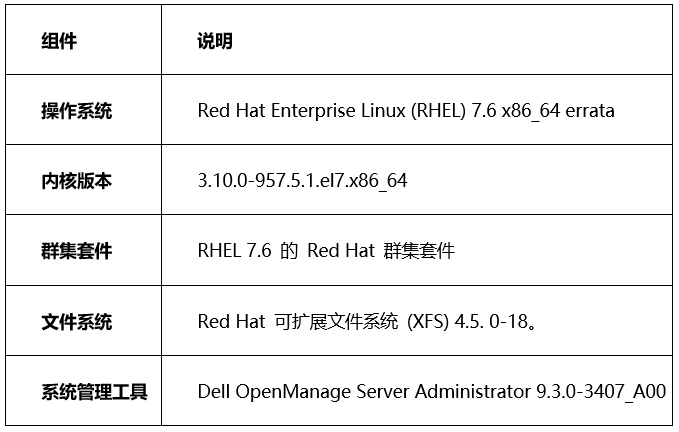

测试配置清单

NSS7.4-HA服务器软件版本?

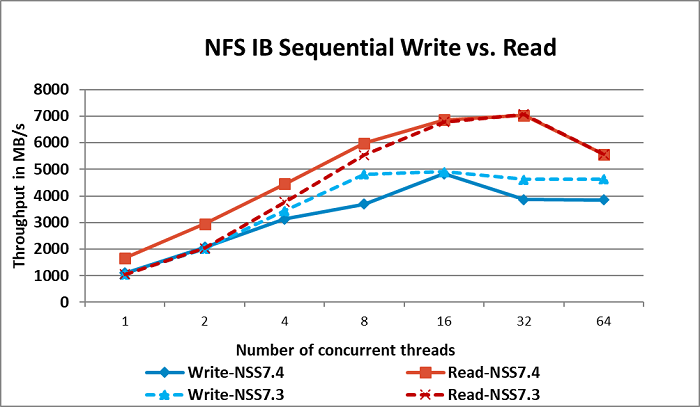

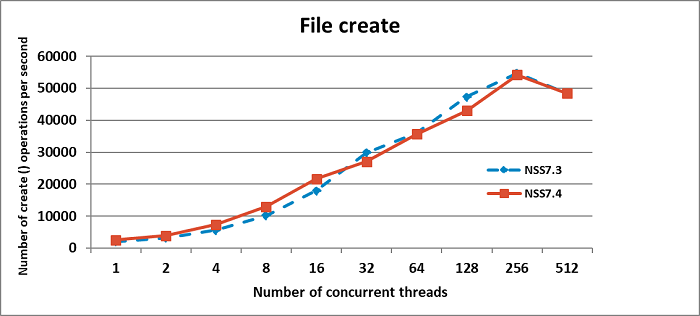

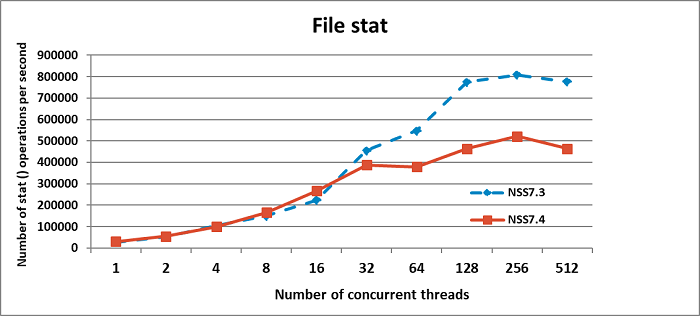

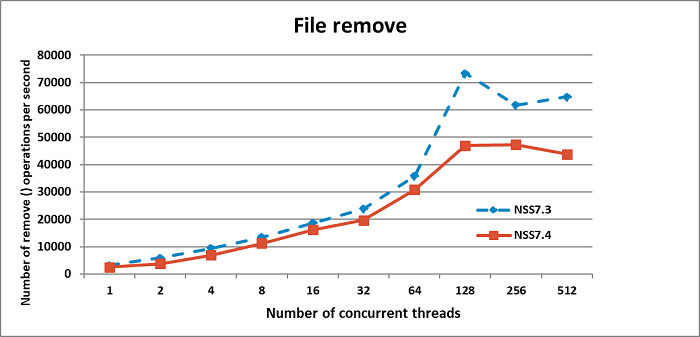

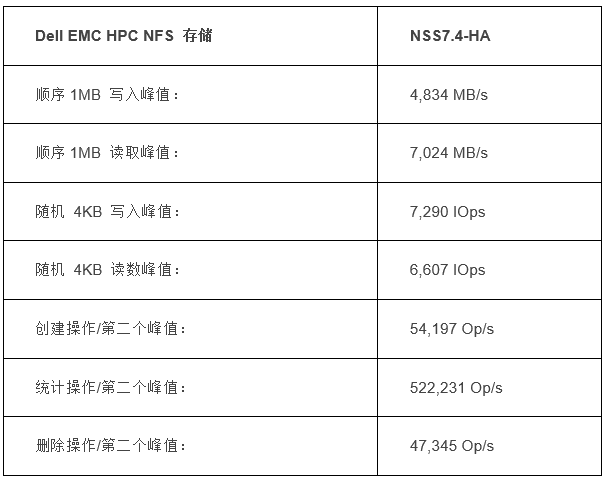

NSS7.4解决方案的I/O性能测试中,所有性能测试均在无故障的情况下进行,以测量解决方案的最大能力。测试重点是三种类型的I/O模式:大量的顺序读取和写入、小量的随机读取和写入,以及三项元数据操作(文件创建、统计和删除)。

840TB(原始存储大小)配置通过EDR上的IPoIB网络连接进行了基准测试。使用32个节点计算群集来生成基准测试的工作负载。每个测试都在一系列客户端上运行,以测试解决方案的可扩展性。

本研究中使用了IOzone和mdtest基准。IOzone用于顺序和随机测试。对于顺序测试,使用了1024KiB的请求大小。传输的数据总量为2TB,以确保NFS服务器高速缓存达到饱和。随机测试使用了4KiB请求大小,每个客户端读取并写入一个4GiB文件。使用mdtest基准配合OpenMPI执行了元数据测试,包括文件创建、统计和删除操作。

IPoIB大规模顺序I/O性能

IPoIB随机 I/O性能

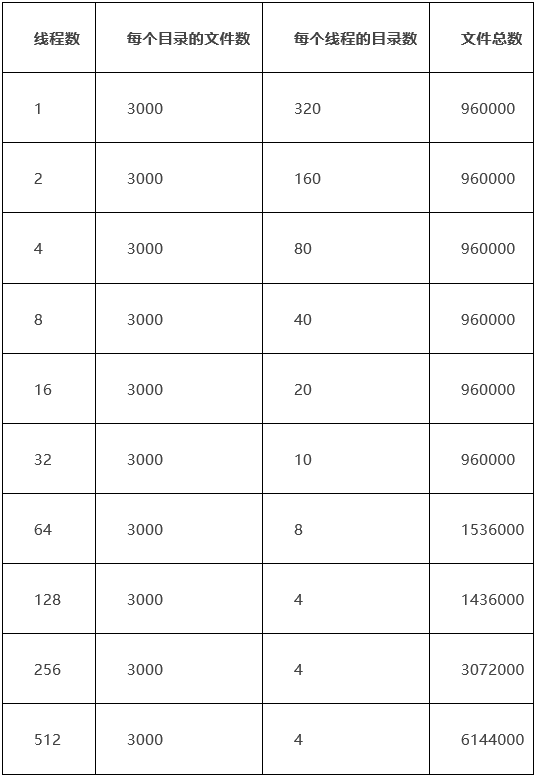

为了评估系统的元数据性能,使用了MDTest工具版本1.9.3。使用的MPI发行版为OpenMPI版本1.10.7。执行元数据测试的方法是:为最多32个线程数创建960000个文件,然后增加文件数,以测试解决方案的可扩展性,如表列出的结果。

元数据测试:跨线程分发文件和目录?

IPoIB文件创建性能

IPoIB文件统计性能

IPoIB文件删除性能

测试结果汇总

适用于HPC NFS存储的Dell EMC Ready解决方案具有如下优势:

提供基于标准的戴尔易安信PowerEdge服务器、PowerVault ME4存储产品以及Redhat的可扩展文件系统帮助用户部署NFS服务器,以达到最佳性能及可靠性。缩短用户的安装时间,降低了规划和部署存储系统的成本。

针对HPC NFS存储的Dell EMC Ready解决方案对吞吐量性能进行了调整,存储单柜可支持5U84块硬盘,可提供7GB/s的读和4.8GB/s写性能。

通过在受支持的单个命名空间中轻松扩展多达64个节点,可以更轻松地满足未来需求,从而以更快的吞吐量运行更大、更复杂的应用程序。

另外,戴尔科技提供提供针对Dell EMC HPC NFS存储解决方案的安装和实施服务,戴尔科技现场部署工程师可将此解决方案部署至您的HPC环境或非HPC环境中,确保您的存储解决方案获得成功。

END

动手指“盘”它

进入戴尔易安信解决方案中心

点击“阅读原文”开启超值盲盒

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

- 1 中央经济工作会议在北京举行 7904834

- 2 紧急提醒:请在日中国公民进行登记 7808487

- 3 中央定调明年继续“国补” 7713361

- 4 “九天”无人机成功首飞 7616489

- 5 断崖式降温!今冬最强寒潮来了 7521806

- 6 中央经济工作会议释信号:3件事不做 7429410

- 7 中国“空中航母”首飞成功 7327823

- 8 《时代》周刊2025年度人物公布 7233853

- 9 人民空军中日双语发文:大惊小怪 7139406

- 10 寒潮来袭 “速冻”模式如何应对 7041824

企业网D1net

企业网D1net