仅需原始参数的2%,全新胶囊网络Efficient-CapsNet效果依然「强势」

新智元报道

新智元报道

来源:外媒

编辑:keyu

【新智元导读】来自意大利的科学家提出了一种新型的胶囊网络,相对传统的CNN,仅需要原始版本胶囊网络参数的2%,就可以在多个数据集上获得最先进的结果。此外,他们还引入了一种基于自注意机制的非迭代路由算法,可以有效应对后续层胶囊数量减少的问题。

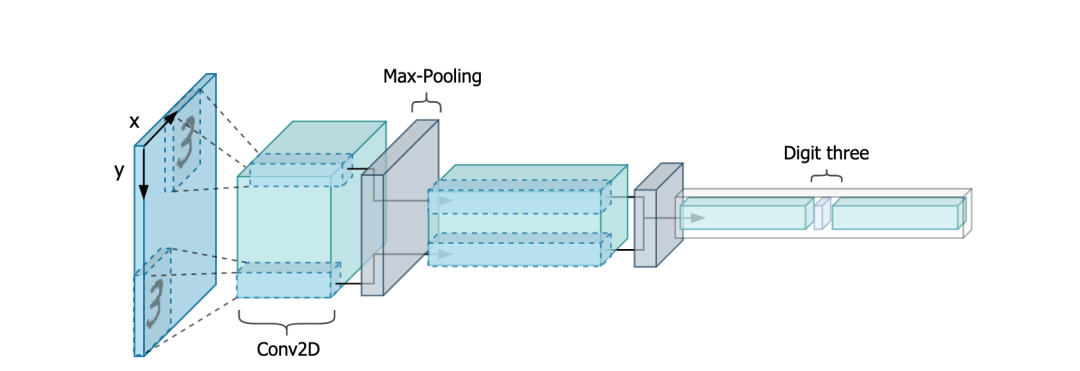

我们都知道深度卷积神经网络是依靠大量的数据和具有大量特征映射的层来完成学习和更新的,这个过程并不是非常高效,对于大型数据集来说,这意味着有大量冗余的特征检测器。

针对这一问题,胶囊网络是一个有发展潜力的解决方案——它可以扩展当前的卷积网络,并可以令人工视觉感知到高效编码所有特征仿射变换的过程。

由于内在具有更好的概括能力,一个胶囊网络理论上可以使用相当少的参数数量,并获得更好的结果。

可惜的是,注意到这一点的人并不多。

不过,近日,来自意大利的研究者提出了一种高效的自注意路由胶囊网络(Capsule Network with Self-Attention Routing, Efficient-CapsNet):

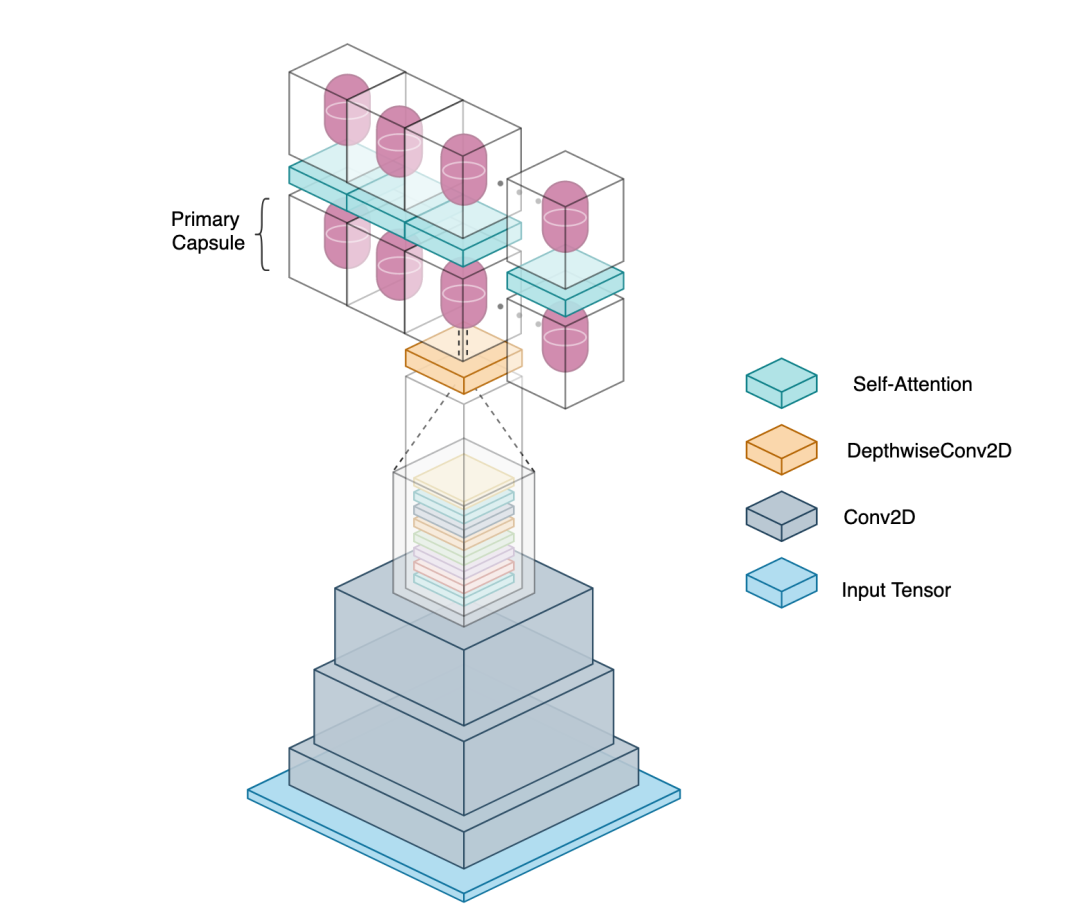

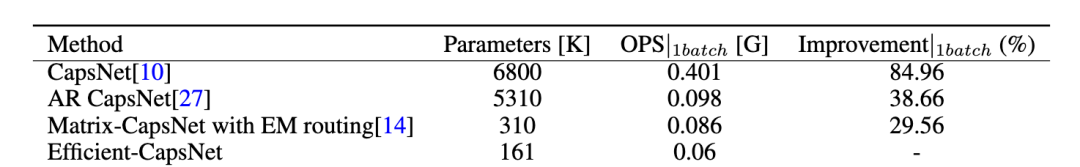

他们深入研究了胶囊网络的的效率,并在参数仅仅有16万的情况下,将网络的性能推到了极致。

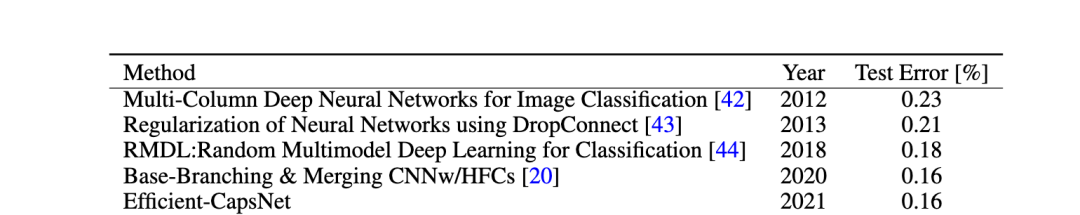

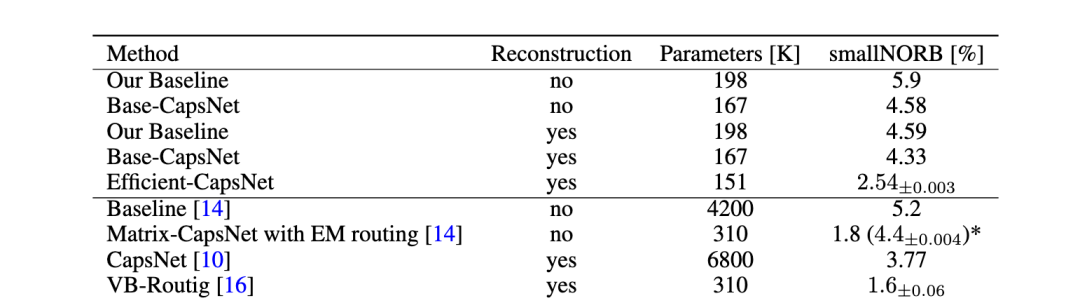

在实验部分,研究者证明,他们提出的架构,在参数量降低为原始CAPSNET的2%的情况下,还可以在三个不同的数据集上实现最先进的结果。

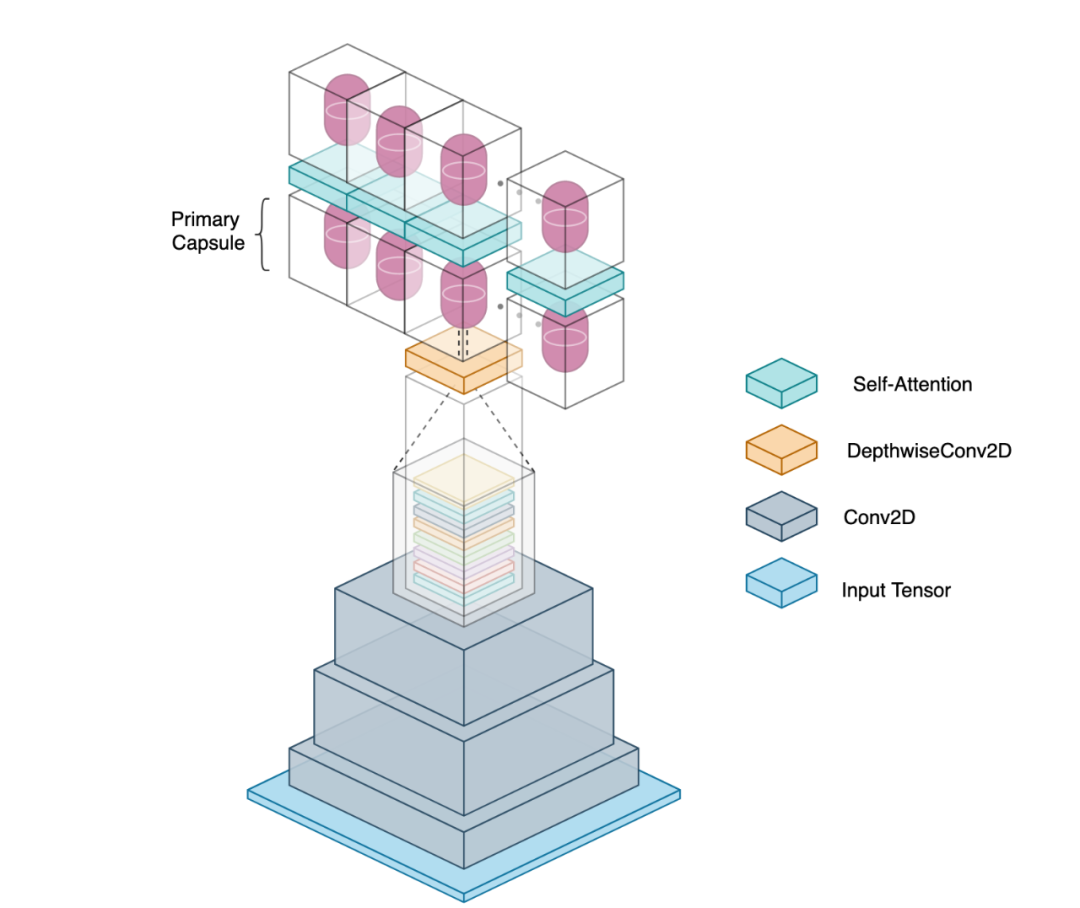

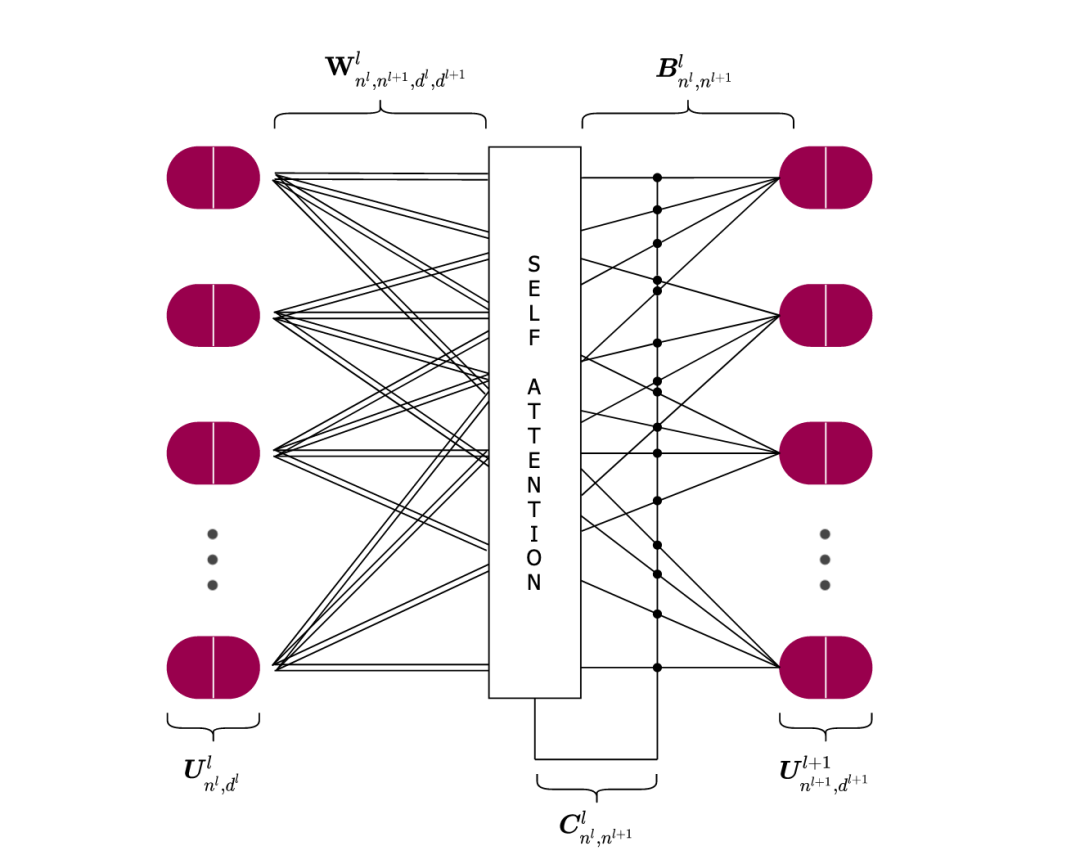

此外,研究者用一个新颖的非迭代、高度并行的的路由算法替代了动态路由,利用自我注意机制,这种新颖的算法可以很容易地对小数量的胶囊进行处理。

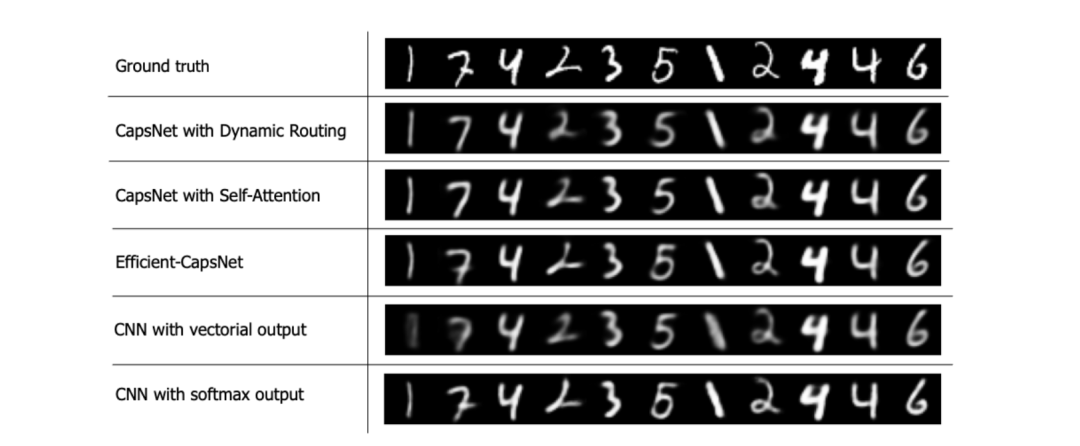

最后,研究者还在其他胶囊上做了额外的实验,结果证明了Efficient-CapsNet的有效性,也证明了胶囊网络可以有效嵌入更为泛化的可视化表示这一特点。

该论文的贡献主要在于:

深入研究了基于胶囊的网络的泛化能力,与以前的文献研究相比,大大减少了可训练参数的数量 概念化和开发了基于胶囊的高效、高度可复制的深度学习神经网络,并能够在三个不同的数据集上达到最先进的结果 引入了一种新颖的非迭代、高度并行的路由算法,即使胶囊数量减少了,该算法也能利用自我注意机制来对其进行有效的路由

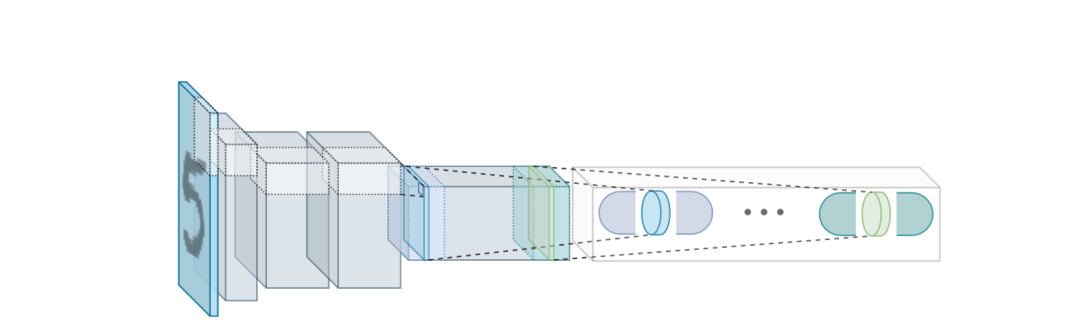

三层宝塔结构:两层不同卷积处理+自注意力机制

操作简单,参数量大幅降低,效果依然显著

操作简单,参数量大幅降低,效果依然显著

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

- 1 文化强国建设谱写时代华章 7903958

- 2 再这么下去苹果要吃不起了 7808002

- 3 不是母子 不是考公 不是舍不得打车 7714105

- 4 外国商家为何爱上“中国购” 7618271

- 5 消失的ATM机:全国仅剩80万台 7522907

- 6 AI独角兽崩塌 全是印度程序员冒充 7424169

- 7 网警重拳出击 摧毁一网络水军团伙 7328217

- 8 哈佛中国留学生:没想到成历史一部分 7235851

- 9 湖南一发改局干部从办公楼5层坠楼 7137672

- 10 辛柏青:身如不系之舟 7048682

![卢颖儿bb[兔子][兔子] 谁能告诉我直播怎么调美颜好看呀 ](https://imgs.knowsafe.com:8087/img/aideep/2022/10/8/039b29dadcaabbef6499b9f65380be66.jpg?w=250)

新智元

新智元