两图生万物!这个超强图像转换神器,小样本一秒猫狗合体变新物种

新智元原创

新智元原创

编辑:元子

【新智元导读】将毫不相干的两个动物P在一起,会诞生什么样的神奇物种?今日,波士顿大学和英伟达合作推出一个小样本图像到图像转换的框架,可以将任意两张动物图片合成一个全新物种,同时保持两张原图的典型特征。论文已被ECCV接收。

小样本,大成就!

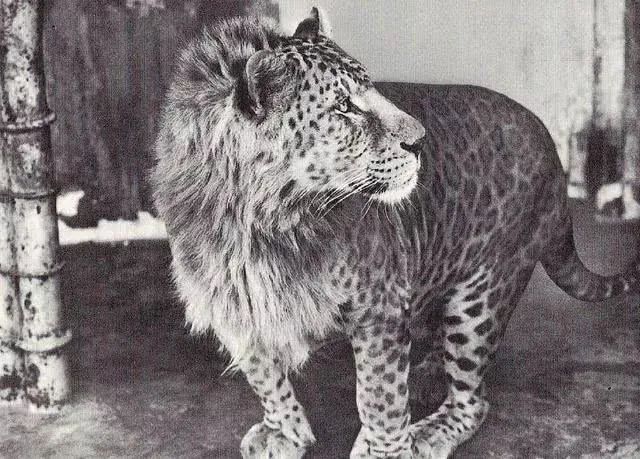

动物界,不同物种之间的杂交产生出了很多新的物种。比如说马和驴杂交出现了骡子;狼和狗杂交出现了狼狗;狮和虎杂交出现了狮虎兽和虎狮兽;豹子和狮子杂交出现了豹狮兽等等。

你是不是也跟我一样。十分好奇将毫不相干的两个动物P在一起,会诞生什么样的神奇物种?

最近波士顿大学和英伟达合作,推出了一个小样本无监督图像翻译编码器:COCO-FUNIT。

只要给COCO-FUNIT任意两张图片,就可以生成一个毫无违和感的合成图片,保留了两个原图各自最典型的特征,但是一个全新的物种。该论文也被ECCV 2020接受,论文地址:

https://arxiv.org/pdf/2007.07431.pdf

先上两个视频感受一下。

第一个视频是官方的介绍,第二个视频是第三方做的实例。

该项目是基于此前英伟达、康纳尔大学和阿尔托大学联合发表了一篇文章——小样本(few-shot)非监督图像到图像转换。论文地址:

https://arxiv.org/pdf/1905.01723.pdf

简单来说,就是输入一只金毛,在训练过程当中,即便第一次看到一种新动物,也能让它像金毛那样吐舌头、闭嘴巴、歪头。

若是输入一张炒面的图,该模型也可以让其它食物变成炒面。

这项工作还提供了在线测试:

https://nvlabs.github.io/FUNIT/petswap.html

我们提出的FUNIT框架旨在通过利用在测试时可用的几个目标类图像,将源类的图像映射到目标类的类似图像。

为了训练FUNIT,我们使用来自一组对象类(例如各种动物物种的图像)中的图像,称为源类(source classes)。我们不假设任何两个类之间存在配对的图像(即,不同物种的任何两个动物都不会是完全相同的姿势)。

我们使用源类里的图像来训练一个multi-class无监督图像到图像转换模型。

在测试过程中,我们从一个称为目标类(target class)的新对象类中提供少量几张图像。模型必须利用少量的目标图像来将源类里的任何图像转换为目标类里的类似图像。

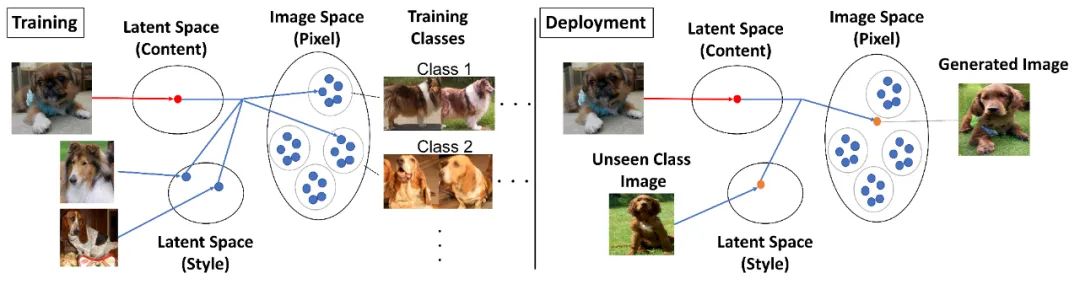

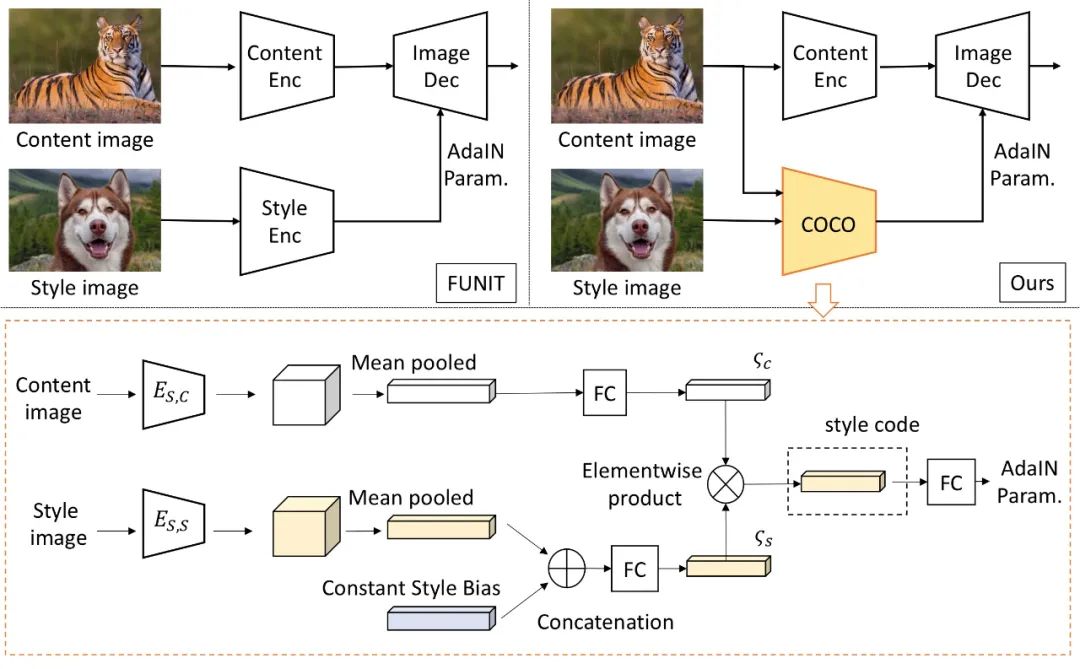

图1

训练。训练集由各种对象类(源类)的图像组成。我们训练了一个模型在这些源对象类之间转换图像。

部署。我们向训练模型显示极少量目标类里的图像,这就足以将源类的图像转换为目标类的类似图像了,即使模型在训练期间从未见过目标类的任何图像。

需要注意的是,FUNIT生成器有两个输入:1)一个内容图像;2)一组目标类图像。它的目的是生成与目标类图像相似的输入图像的转换。

我们的框架由一个有条件的图像发生器G和一个多任务对抗性鉴别器D组成。

与现有无监督image-to-image translation框架中有条件的图像生成器不同,它们是将一张图像作为输入,而我们的生成器G需要同时将一张内容图像x和一组K类图像{y1, ..., yK}作为输入,生成输出图像x¯,公式如下:

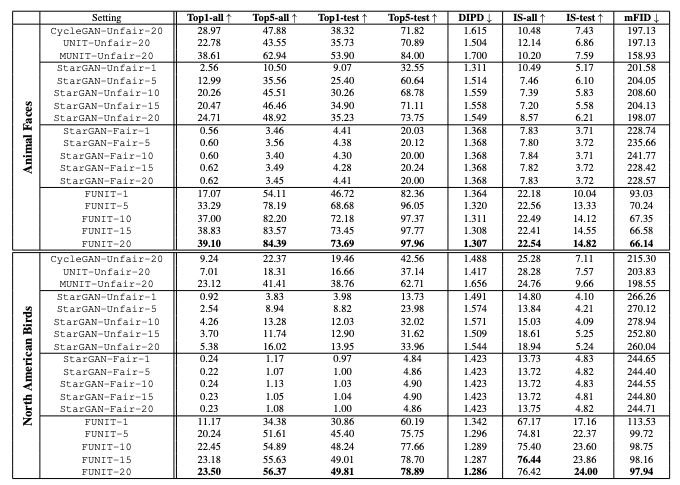

主要结果

如表1所示,FUNIT框架在Animal Faces和North American Birds两个数据集的所有性能指标都优于用于小样本无监督图像到图像转换任务的基线模型。

FUNIT在Animal Faces数据集的1-shot和5-shot设置上分别达到82.36和96.05 的Top-5 测试精度,以及在North American Birds数据集上分别达到60.19和75.75的Top-5 测试精度。

这些指标都明显优于相应的基准模型。

表1:FUNIT与基线模型的性能比较。↑表示数值越大越好,↓表示越小越好。

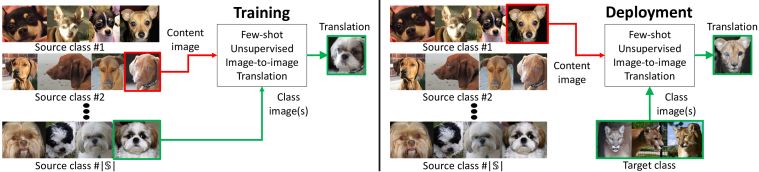

在图2中,我们对FUNIT-5计算的few-shot translation的结果进行了可视化。

图2:无监督图像-图像转换结果的可视化。计算结果采用FUNIT-5模型。

从上到下分别是来自动物面孔、鸟、花和食物数据集的结果。每个示例随机展示了2张目标类中的图像,输入内容图像x,以及转换后的输出图像x¯。

结果表明,模型能够成功地将源类的图像转换为新的类中的相似图像。对象在输入内容图像x和相应输出图像x¯中的姿态基本保持不变。输出图像也非常逼真,类似于目标类中的图像。

图3提供FUNIT与基线模型的结果比较。可以看到,FUNIT生成了高质量的图像转换输出。

图3:小样本图像到图像转换效果的比较。

从左到右的列分别是输入内容图像x,两个输入目标类图像y1,y2,来自不公平的StarGAN基线的转换结果,来自公平的StarGAN基线的转换结果,以及来自FUNIT框架的结果。

## 解决Content Loss问题

然而,上述论文中提出的框架在一个方面受到了限制。当模型应用于具有不同外观的对象时,如具有非常不同身体姿势的动物时,少数镜头翻译框架经常产生不满意的翻译输出。

如上图所示,本应保持不变的领域不变的内容在翻译后消失了。作者将这个问题称为内容丢失(Content Loss)问题。

对此,本论文作者提出了一种新型的网络架构来解决内容丢失问题。通过设计一种称为content-conditioned style encoder的风格编码器,以阻止任务相关的外观信息传输到图像翻译过程中。

与现有的风格编码器不同,风格代码是通过对输入内容图像进行调节来计算的。作者使用了一种新的架构设计来限制风格代码的变化。

最终效果:

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

- 1 习近平向中国西部国际博览会致贺信 7904539

- 2 王楚钦拿下三大赛单打首冠 7808209

- 3 王楚钦说心头多年的结解开了 7711949

- 4 美线货运订舱就像“抢票” 7616701

- 5 孙颖莎哭了 7523972

- 6 男子投资180万开超市 开业7天被举报 7424185

- 7 机器人在格斗大赛打裁判 7328838

- 8 王楚钦仰天狂笑 7238032

- 9 哈妮克孜因为戴眼镜探班被换角 7142608

- 10 高志凯:中国绝不允许你开第二枪 7046183

新智元

新智元