原定于昨天推送的 iOS 13.2 开发者预览版并没有如期而至,而是推迟到了今天凌晨。虽然说时间上推迟了,可这次的更新,却为各位 iPhone 11 系列用户带来了不小的惊喜,因为 Deep Fusion 来了。这个被苹果高级副总裁菲尔·席勒称为「计算摄影的疯狂哲学」的功能,可以在用户按下快门前拍摄 8 张照片,并融合一张按下快门时的长曝图片,生成一张媲美专业相机的高动态范围照片,即便在中低光环境下也能呈现更多细节。Deep Fusion 这项今年三款新 iPhone 独占的功能,并没有随着新 iPhone 的开售而到来。但经过将近一个月的等待后,它终于还是来了。大家都知道,在过去的机型中,苹果就已经通过 Smart HDR 来帮助用户拍摄出高动态范围的照片。自然而然,苹果用户最关心的,相信就是,Deep Fusion 与前者有何差异。加拿大摄影师 Tyler Stalman 就将 iPhone XR 上的 Smart HDR 与 iPhone 11 上的 Deep Fusion 进行了对比。从样张中我肯可以看到,确实在开启 Deep Fusion 后,样张确实会有更为丰富的细节表现。

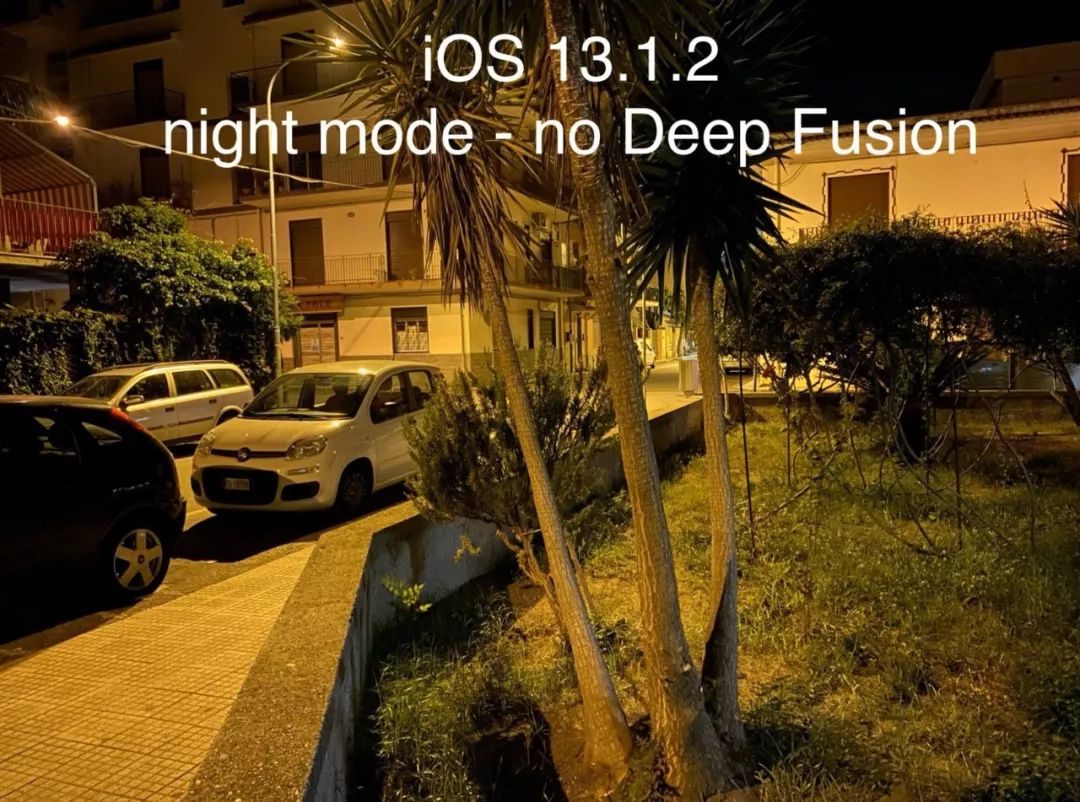

另一组样张则是来自国外科技博主 Chuck Skoda,他直接将样张进行了 100% 的放大,然后对比了 Smart HDR 与 Deep Fusion 的表现。(左边为 Smart HDR,右边为 Deep Fusion)另外,科技博主 domenico 也在其推特中发出了一组在夜景中开启 Deep Fusion 的对比照。相比起日间,在夜景中 Deep Fusion 对细节还原的提升似乎更大。

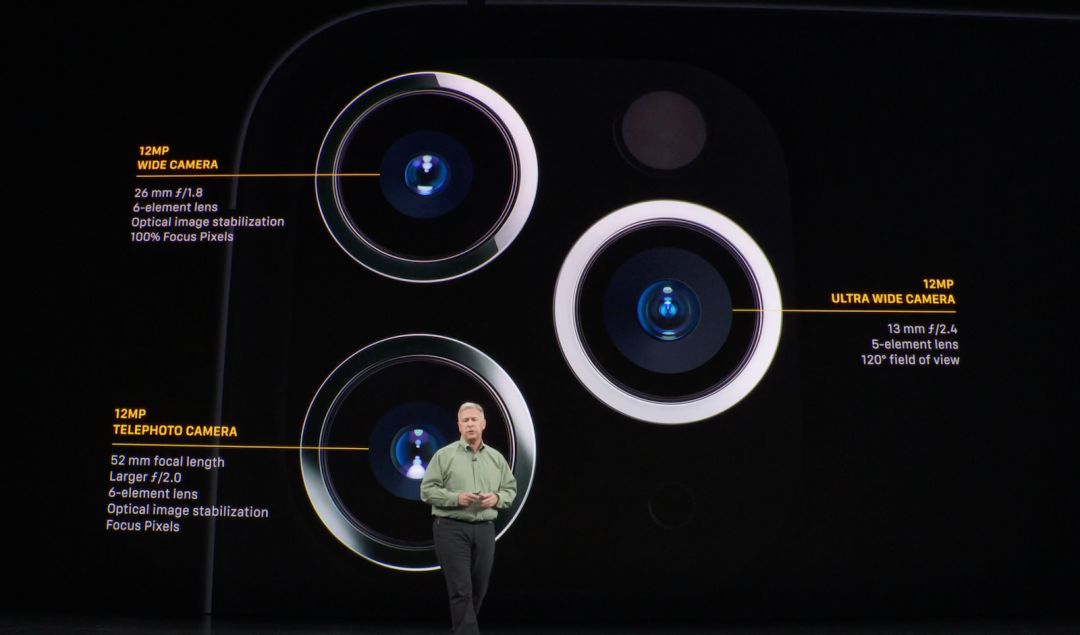

实际上,新 iPhone 在摄影上的突破,主要归功于算力更强大的 A13 仿生芯片上。这块芯片相比起前代,CPU 速度最高可提升 20%,能耗最多可降低 30%,而四个能效核心速度提升了 20%,能耗却降低了 40%。另外,A13 仿生新增了两个新的机器学习加速器,能以最高达 6 倍的速度执行矩阵数学运算,每秒可进行 1 万亿次的运算。更强大的算力,才得以保证 Deep Fusion 的实现。与 Smart HDR 不同,Deep Fusion 的合成并不需要经过 ISP,而是当你拍摄了更多的照片数据时,它们会直接给到神经网络引擎,神经网络引擎具备一种全新的模型,可以整合大量的照片——它会对 2400 万像素进行逐一像素的比对,从而合成最终的照片。延续苹果一贯的概念,也就是尽量让拍摄变得简单,Deep Fusion 并没有开关。系统会自动根据拍摄环境来判断是否需要开启 Deep Fusion。在此前,席勒也透露 DeepFusion 只会在 10-600lux 下的照度下激活,如果光线低于 10 lux,相机启用的则是夜间模式。外媒 The Verge 则进一步发现,新 iPhone 上三颗不同的镜头,实际上开启 Deep Fusion 的条件是不一样的。首先广角镜头会在明亮至中光的环境下启用 Smart HDR,在中光到暗光的环境下会启用 Deep Fusion,而在几乎黑暗的环境下则会启用 Night Mode。所以席勒上面所讲以 10lux 以及 600lux 作为划分线的启用逻辑,指的应该是使用广角镜头的时候。其次在使用长焦镜头的时候,仅仅会在非常明亮的环境下才会启用 Smart HDR,其余场景则只会使用 Deep Fusion。而最后由于超广角镜头是不支持 Deep Fusion 以及 Night Mode 的,所以在该镜头时则只会启用 Smart HDR。在接受我们的采访,被问到 Deep Fusion 合成一张照片所要的时间时,席勒表示仅需要一秒。确实很快,但是这一秒还是能够感受得到的。据论坛中已经率先体验 Deep Fusion 的用户反映。拍完照之后进入相册,找到你刚刚拍下的照片时,你会发现照片会「抖」一下,然后才会重新展现一张与原先有明显区别的照片。更多的照片信息,也就意味着这张照片需要占你更多的空间。iPhone XR 上的 Smart HDR 照片大小为 1.4MB,iPhone 11 上的 Deep Fusion 大小则进一步上升至 2.4MB。所以奔着 Deep Fusion 这个功能而购买新 iPhone 的用户,可要好好地考虑容量问题了。

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号

爱范儿

爱范儿