让电脑说人话 | 数字化转型 ING

(本文阅读时间:10分钟)

软妹有话说:快节奏的生活,使得信息获取更加碎片化,媒体如何能借助 AI 赋能内容生产,实现更有效的传播?近日,《三联生活周刊》旗下新媒体平台——“中读”与微软合作,借助微软深度神经网络技术智能合成声音,生成高质量的有声音频节目,支持多种语音风格切换;并将继续在声音的交互、搜索与推介上谋求新突破。《三联生活周刊》资深主笔袁越(笔名:土摩托)还与微软合作,基于个性化智能语音定制技术定制了专属声音。定制语音的经历和感受究竟是什么样的?咱们读读这篇文章~(PS:文中音频有两段语音,哪个是人声?哪个是 AI 的声音?在评论区给出你的答案,并说说理由,答对且被点赞数最多的五名小伙伴有奖哦~)

如今流行音频课,人们可以把平时花在通勤和锻炼上的时间利用起来听书学习。不久前,三联中读打算把我在杂志上写的《生命八卦》专栏做成音频,我立刻表示反对,因为那个专栏我写了 15 年,加起来超过了 80 万字。我可不想把自己关在录音棚里一遍又一遍地朗读旧文,那是要死人的。

根据两位博士介绍,传统的中文语音合成技术大致可以分为前端和后端这两部分,前端的主要任务是对输入的文本进行语义分析,即把一个个单独的中文字进行分词断句,并标注出每个词的词性,因为中文有多音字的问题,不同的词性读音很可能不一样,韵律也会有所不同。之后还要进行一次归一化处理(Normalization),比如 110 用在电话号码里应该读成幺幺零,而不是一百一十。前端部分需要电脑掌握基本的语言规则,机器学习程序也可以得到部分应用。

后端处理有两种不同的模式,一种叫拼接合成,即把每句话切成一个个小片段,然后从语音库里调出相应的片段加以拼接。这个过程有点像搭乐高,或者更准确地说,像间谍写信时为了不让对方看出笔迹而从报纸上找单词,再剪下来拼接。另一种模式叫做参数合成,让电脑根据前端的语义分析结果预测相应的声学特征序列,再用声码器直接进行声音的合成。

这两种模式本质上都是基于统计的选择,即哪种方式人类用的比较多就选择哪种。相比之下,拼接合成模式做出来的声音更像真人,只不过会有点跳跃,不够平滑。参数合成模式做出来的声音则正相反,听起来非常平滑,但却会显得单调无趣,缺乏个性,而且声音会有点发闷,一听就是电脑做出来的。

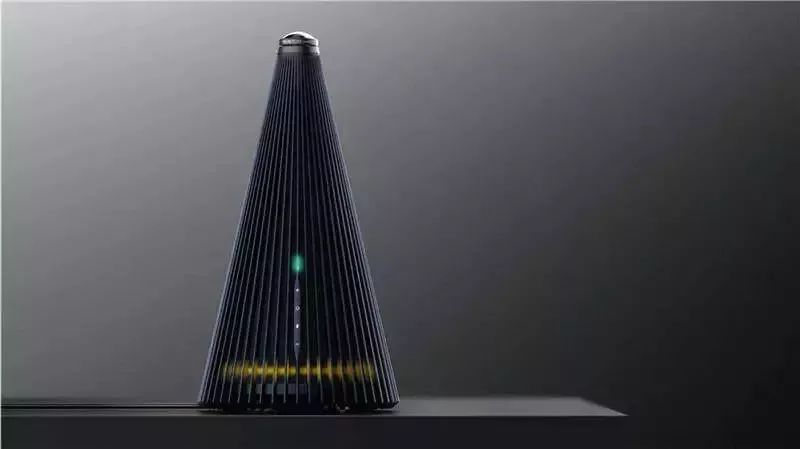

配备摄像头和麦克风阵列的智能会议系统“黑塔”

从电脑的角度来看,拼接合成模式需要的计算量比较大,通常需要联网才能使用。参数合成模式需要的计算量比较小,适合离线状态,所以我们平时听到的导航声音大都是用参数合成的办法做出来的。但像一些名人声音,比如郭德纲或者林志玲的定制声音,则是两者结合的产物。

微软早在 2003 年就成立了语音组,致力于开发电脑语音处理系统。在上述这两种传统方法的基础上,该组于去年开始尝试一个根本性的技术革新,即把目前最火的深度神经网络技术用了进来,最大限度地模仿人类说话的方式。

“我们平时说话的时候,肯定不会先在心里分词断句,再标词性标韵律,而是想到什么直接就说出来了,因为语言规则早就存在我们的脑子里了。”丁秉公对我说:“于是我们如法炮制,直接把大量的文字以及相应的语音信息输进电脑,训练深度神经网络去学习这些真人的说话方式,这样学出来的语音包含有大量真人说话特有的声音细节,甚至像换气和咽口水等等细微的声音都可以模仿出来,这就为声音定制提供了可能性。”

“我那天只给你们录了几百句话,这么点训练量怎么够呢?”我问。

“因为我们的系统事先已经学习了成百上千个不同人的声音,得到了一个普适的通用模型(Universal Model),然后我们只要把你的个人特征加进这个已经训练好了的系统里,进行一下优化就可以了。”何磊这样解释:“优化好的系统就只适用于你一个人,读任何东西出来的都是你的声音,这就是我们的声音定制服务。”

据介绍,目前这套系统已经可以商用,背后有微软云计算平台 Azure 强大的计算能力作为支持。这就好比当年和李世石对弈的第一代阿尔法围棋程序,后台有一大堆计算机在疯狂地工作着。经过不断地优化,和柯洁对弈的第二代阿尔法围棋程序就可以在一台单机上运行了,这套系统也正朝这个方向努力。

“我们这套 Neural TTS 系统本质上仍然是基于统计的,不是真正意义上的阅读理解,所以还是会犯错,对于准确率要求较高的场景,后期需要编辑进行校验和修改。”丁秉公告诉我,“其实真人录音同样需要后期处理,工作量也很大,而我们这套系统的好处是可以先批量生产出一大批音频文件,投放到市场上去,然后根据听众的反馈,挑出最受欢迎的书籍或者文章,再找真人专门录一个高质量的音频版本就行了。”

何磊给我播放了几段演示音频,同样一个女声,既可以说中文和英文,也可以说德语、法语、日语和西班牙语,甚至连四川话都能说。

“其实我们做这套系统不光是为了制作音频节目,还可以帮助视障人员或者渐冻症患者发出自己的声音。”丁秉公告诉我,“假设一个人知道自己得了渐冻症,即将在不远的将来失去说话的能力,我们可以事先把他的声音录下来,然后他就可以通过电脑用自己的嗓音和外界通话了。

聊了半天语音合成,我顺便问了问语音合成技术的恋生兄弟,语音识别技术的现状。作为一名记者,这个功能也是非常有用的,能够帮助我整理采访录音。

“微软从上世纪 90 年代起就开始研究语言识别技术了,当时还只能做到 50% 的准确率,没法实用。”丁秉公介绍说,“经过多年的努力,2017 年时我们已经可以把错误率降到 5.1%,也就是说每 100 个字只听错 5 个,这个成绩已经比真人要好了。”

我用微软提供的麦克风试了试,故意夹杂了一句含混不清的北京土话,居然被正确地识别了出来。

“你这个叫近场识别,准确度最高。如果声源距离麦克风超过了一米远,叫远场声,电脑虽然也能识别出来,准确率就没有那么高了。”丁秉公解释说:“除此之外,我们还得考虑环境噪声的影响、回声的干扰、录音质量过低的问题,以及从多人对话中分辨出谁在说话,难度非常大。”

为了解决最后这个问题,可以事先对每一位说话者进行几分钟的声音采样,让电脑学会这些人的声音特征。但很多时候这是不可能做到的,此时就得想点新的招数。丁秉公为我演示了微软出的一套全新的会议记录系统,除了麦克风之外还添加了若干个摄像头,帮助电脑更好地辨别出是谁在说话。如果会议室里安装了这套系统,会议结束后就可以立即拿到完整的会议记录,非常方便。

在电脑语言这个案例里,语音合成就是一个定义明确的任务。输入电脑的原始数据是真人在录音棚里对着麦克风朗读出来的,和对应的文本一字不差,数据非常干净。用这样的数据训练电脑,可以更好地利用深度神经网络强大的学习能力。相比之下,训练电脑语音识别时所输入的原始数据就显得比较“脏”了,电脑最怕这种模糊的东西,处理起来就要困难得多。

中国企业携手微软,无惧出海四大挑战

电商新玩法,微软与小程序提供商酷客多达成技术创新合作,多重好礼大放送

【行业“微”洞察】:解锁智能制造新招式

最新活动

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

- 1 打好关键核心技术攻坚战 7904038

- 2 在南海坠毁的2架美国军机已被捞出 7808963

- 3 立陶宛进入紧急状态 卢卡申科发声 7712669

- 4 持续巩固增强经济回升向好态势 7618122

- 5 多家店铺水银体温计售空 7522949

- 6 奶奶自爷爷去世9个月后变化 7423699

- 7 中科曙光终止重大资产重组 7328109

- 8 日舰曾收到中方提示 7232607

- 9 监拍一货车燃油被人用软管吸走 7138584

- 10 我国成功发射遥感四十七号卫星 7039778

![张幺姬Zora_蓝莓抹茶小蛋糕,想做你的小奶猫[熊猫]](https://imgs.knowsafe.com:8087/img/aideep/2022/12/11/af99410968585679ddde0f5bd3f4f8db.jpg?w=250)

微软科技

微软科技