总有人会浅薄地认为,你只是加了一个摄像头,世界上也有其他超广角摄像头了,这有啥新鲜的?菲尔・席勒(Phil Schiller)拿起桌上的一部 iPhone 11,打开相机,他指着屏幕两侧延伸出的取景画面对我说:眼前这位负责营销的苹果高级副总裁,看起来比镜头前清瘦不少 —— 在紧锣密鼓的苹果发布会上,席勒掌控着关于产品和技术层面的讲解时间。但我们没有时间在 Keynote 上解释它具体是如何发生的,但它就在那里,从来没有人做过。在大约 40 分钟的专访里,尽管我试图把对话引向更符合这位高管身份的话题上,但这位具备技术背景的高级副总裁,却始终滔滔不绝地向我吐露发布会上他没来及说的技术细节。

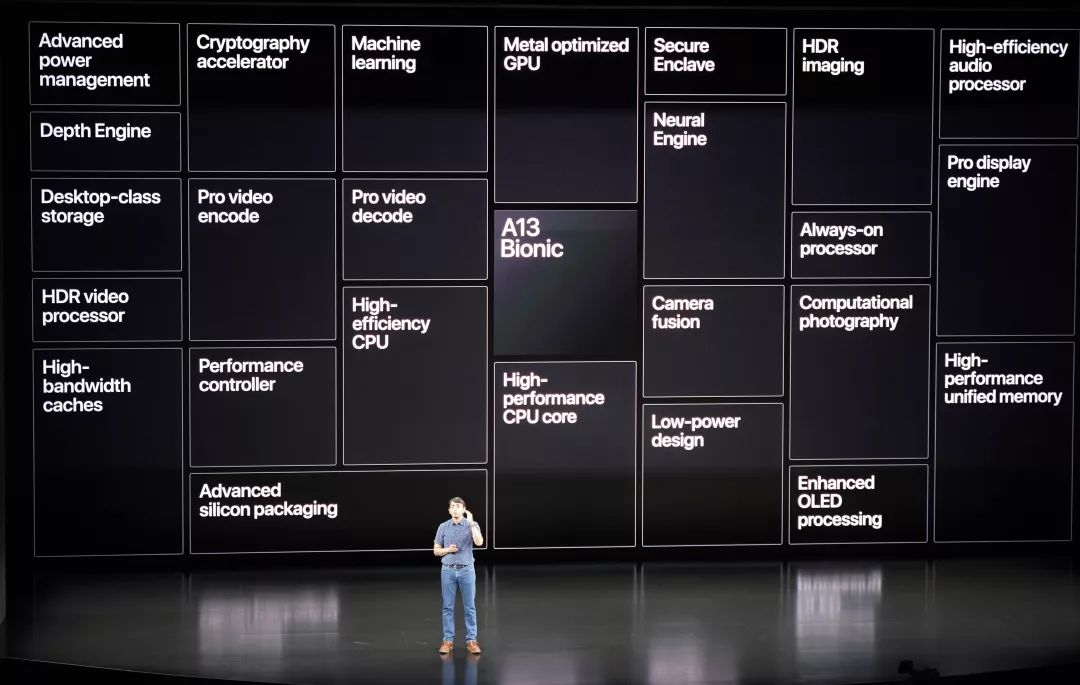

正如我们此前评测,无论是三摄变焦的毫无顿挫,还是夜间模式的纯净度,iPhone 的摄影都再一次回到行业领先的位置。席勒把 iPhone 11 摄影的突破归功于 A13 仿生芯片上。这块由苹果自研的第二代 7nm 芯片, 依然采用 2+4 的设计,即两个高性能核心和四个能效核心设计,其中 CPU 速度最高可提升 20%,能耗最多可降低 30%,而四个能效核心速度提升了 20%,能耗却降低了 40%。席勒认为,机器学习是 A13 仿生芯片区别于 A12 设计的一个重点,CPU 上新增了两个新的机器学习加速器,能以最高达 6 倍的速度执行矩阵数学运算,每秒可进行 1 万亿次的运算。在相同的尺寸里,A13 仿生芯片比上一代多塞进了 11 亿个晶体管。那么,多出算力花在哪里?最好的例子莫过于 Deep Fusion,这个被席勒称为「计算摄影的疯狂哲学」的功能,可以在用户按下快门前拍摄 8 张照片,并融合一张按下快门时的长曝图片,生成一张媲美专业相机的高动态范围照片,即便在中低光环境下也能呈现更多细节。 席勒在发布会上介绍 Deep Fusion

席勒在发布会上介绍 Deep Fusion

席勒向我解释了它与智能 HDR 的不同:在正常情况下,智能 HDR 是通过多张图片的堆栈得到一张更好的照片,ISP 提供数据负责最后的成片,神经网络引擎只是协助成片。ISP 意为图像信号传感器,主要负责讲传感器上的数据信号转换为屏幕上的图像。iPhone 11 取景框来自两个摄像头同时取景的画面,近乎完美的拼接, ISP 功不可没。但是 Deep Fusion 不一样,当你拍摄了更多的照片数据时,它们会直接给到神经网络引擎,神经网络引擎具备一种全新的模型,可以整合大量的照片 —— 它会对 2400 万像素进行逐一像素的比对,从而合成最终的照片。这是第一次,神经网络引擎主要去负责这个工作,而非 ISP。一秒钟!你只需要关心拍照的事,当你回到相册的时候,它已经静静地躺在那里了。iPhone 的拍照页面保持了 iOS 一贯的简洁,苹果希望帮助用户做选择,但背后却有精确的数字调度。席勒透露,DeepFusion 只会在 10-600lux 下的照度下激活,如果光线低于 10 lux,相机启用的则是夜间模式。不止是苹果,各家智能手机厂商们逐渐意识到,智能手机时代的影像,早已脱离元器件的堆积,不是 CMOS 底大一寸压死人的粗暴逻辑,是感光元件、ISP、算法,甚至机器学习的配合与协同。在 AI 大行其道的今天,当 AI 智慧拍照、 AI 人像、AI 美颜概念几乎成为 Android 手机的金字招牌,苹果显得有些格格不入,在发布会上轻描淡写,对媒体守口如瓶,你甚至在 iPhone 里找不到半个 AI 字眼。在斯坦福教授人工智能历史一课的 Jerry Kaplan 表示,苹果不属于社区的一分子,就像是 AI 领域的 NSA(美国国家安全局)。席勒没有透露更多关于苹果 AI 的进展,但他认为,机器学习的用武之地绝不仅仅在于如何让照片更好看:从 Siri 更自然的人声效果到相册的智能检索,从提升电池续航到 AR 的光影效果,它已经横贯于 iOS 大小功能的细枝末节和用户体验的方方面面。当我猜测说 Apple Pencil 在 iPad 的「防误触」是否来自机器学习算法时,席勒笑着打断我的话:可不止,连 Apple Pencil 的轨迹也是机器学习去预测的,它知道你可能会画到哪里。事实上,机器学习在 iPhone 中无处不在,正如 Backchannel 主编 Steven Levy 提到的,你的 iPhone 早已经内置了 Apple Brain。Apple Brain 就是那颗 A13 仿生芯片 —— 与其他大公司利用云端运算做机器学习不同,苹果调用的完全是本地芯片的能力。

这个「大脑」有多大?iPhone 上有多少用户数据缓存可供机器学习调用?对于绝大多数公司,这个大脑可能是数以 TB 级的云端数据,但对于苹果而言,只有平均 200 MB—— 这些大到你的声音和面部数据,小到你滑屏的轨迹与习惯,都以加密的形式存储在 iPhone 的芯片之上。从用户角度看,这种行为的确令人尊敬,但利用本地芯片做 AI 无疑是一条更艰难的赛道。「的确很难,这意味着我们需要在芯片上投入大量的精力,意味着我们必须找到软件的方式去训练模型。」席勒说:我们愿意这样做,不仅仅是因为本地运算更快,还因为 —— 没有人不在意自己的隐私。自从 2008 年收购芯片制造商 P.A. 半导体,并在 iPhone 4 和初代 iPad 上采用首颗自研处理器 A4,苹果逐渐与 ARM 公版设计分道扬镳。到了 iPhone 5 所采用的 A6 芯片,苹果真正的设计实力与野心才开始逐渐展露。从核心的 SoC,到协处理器、电源管理芯片,苹果正在一步步让半导体元器件的设计掌控在自己手中。苹果芯片的客户只有自己,好处在于自己才更能了解自己需要什么,并将其发挥到最大的价值,从而达到软硬件的高度契合。今年 3 月发布的第二代 AirPods 上,苹果首次为耳机产品研发了芯片组 H1。对于大众而言,H1 芯片带来的升级,远不如加个新配色或是改个外观来得吸引人,但芯片却直接关乎着左右耳连接的稳定性,以及低延迟表现,这恰恰是竞品与 AirPods 差距最大的部分。用户对苹果芯片实力的感知并不直观,很多人觉得 iPhone 好用,却道不出其技术缘由,简单粗暴地把用户体验归为 iOS 的老本。芯片是一个门槛更高的产业,很难被竞争对手模仿与跟随。某种意义上,自研芯片才是 iOS 生态系统的核心,是整个护城河里最坚固的部分。芯片的研发周期大约在 2-3 年,涉及多个团队,这期间架构工程师要同数目庞大的软件和硬件人员共同协作。芯片团队每周都要和其他团队当面沟通。Anand Shimpi 曾是 AnandTech 的创始人,加入苹果后负责芯片业务,就在采访前,他刚刚和 GPU 部门的架构师开了一场会:摄像头经常会用到 GPU。这有两方面影响,芯片部门设计的 GPU 可以告诉相机部门如何把它用到最好,而相机部门的需求也会指导 GPU 未来的发展。接近十年自研芯片的历史让苹果对 A 系列芯片非常自信,不仅发布会史无前例地在 Keynote 吊打两大竞品,在采访中,席勒也毫不掩饰地评论竞争对手:他们很难持久,他们也许会关注单一性能的指标,而我们更在乎每瓦的性能…… 我们不销售芯片,我思考的只是如何让体验更好。采访结束后,当我掏出相机合影时,席勒指着我的相机笑着说:Not very smart camera, but a big lens.

关注公众号:拾黑(shiheibook)了解更多

[广告]赞助链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

让资讯触达的更精准有趣:https://www.0xu.cn/

席勒在发布会上介绍 Deep Fusion

席勒在发布会上介绍 Deep Fusion

关注网络尖刀微信公众号

关注网络尖刀微信公众号

爱范儿

爱范儿